Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

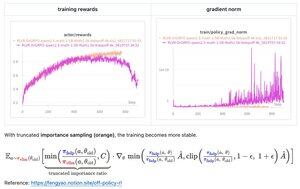

Mit nur wenigen Codezeilen hat Fengs (@fengyao1909) vorgeschlagene Lösung – die Anwendung von Importance Sampling auf die Verhaltenspolitik – die Trainingsinstabilität in meinem Fall (oat) behoben. Ich glaube, dass das Ergebnis auch auf andere RL-Frameworks übertragbar ist. Großartige Arbeit, Feng!

27,64K

Top

Ranking

Favoriten