Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

elvis

Construindo com agentes de IA @dair_ai • Anterior: Meta AI, Galactica LLM, Elastic, PaperswithCode, PhD • Compartilho insights sobre como construir com LLMs & AI Agents ⬇️

Modelos pequenos também podem ser bons raciocinadores.

Aqui está o problema e a solução proposta:

Modelos pequenos muitas vezes pioram quando você os treina com rastros de CoT do professor.

Este artigo atribui a falha ao desalinhamento distributivo e introduz a Decodificação Especulativa Reversa (RSD): durante a geração de rastros, o professor propõe tokens, mas o aluno aceita apenas tokens que são suficientemente prováveis sob sua própria distribuição.

O resultado são rastros amigáveis ao aluno que preservam a correção enquanto mantêm a surpresa passo a passo gerenciável.

A RSD utiliza amostragem por rejeição para selecionar rastros corretos e alinhados e os emparelha com prefixos UPFT para itens não resolvidos: treina rastros completos onde a RSD encontra uma solução correta e treina os primeiros 128 tokens onde não encontra.

Quando aplicada ao Qwen3-0.6B, a destilação direta de dados de rastros de raciocínio s1K-1.1 degrada o desempenho médio em 20,5%, enquanto o mesmo modelo treinado em rastros de raciocínio gerados pela RSD alcança melhorias significativas de 4,9%.

Artigo:

33,69K

Ótimo trabalho ao mostrar a síntese de prompt como um novo eixo de escalonamento para raciocínio.

Dados de treinamento de boa qualidade são escassos.

Este trabalho apresenta uma estrutura que pode tornar possível a construção de problemas de treinamento de alta qualidade para LLMs focados em raciocínio.

Detalhes técnicos abaixo:

55K

É incrível como o GPT-5 é um grande orquestrador.

Se você está construindo um sistema agente semelhante ao Claude Code para qualquer domínio, o GPT-5 deve ser um dos seus principais modelos.

Se você está construindo sistemas multi-agente orquestrador-trabalhador para domínios além da programação, o GPT-5 é imprescindível!

O GPT-5 funciona bem para muitos domínios porque entende a intenção e consegue raciocinar sobre muitos dados de forma eficaz. É ótimo em preencher lacunas, o que ajuda os desenvolvedores que normalmente subespecificam seus agentes.

Os agentes de IA estão cheios de comportamentos emergentes interessantes que beneficiam a experiência do usuário, mas isso só é possível com modelos avançados, como o GPT-5, orquestrando a comunicação entre subagentes.

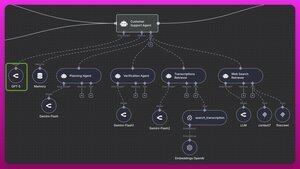

Como mostrado na figura, eu o usei para construir um sistema dinâmico e agente para suporte ao cliente. Um agente orquestrador (potenciado pelo GPT-5) pode planejar de forma eficaz e orquestrar eficientemente a recuperação de todos os tipos de informações (transcrições, KB interna, documentos, fóruns da internet, etc.).

Como este é um sistema de multi-recuperação, você precisa de um modelo extremamente inteligente para lidar com a orquestração, já que os subagentes são deixados flexíveis para puxar todos os tipos de contexto para o sistema. O GPT-5 possibilita essa flexibilidade com sua capacidade de lidar e raciocinar sobre uma ampla variedade de informações.

Se suas definições de ferramentas estiverem corretamente configuradas, isso ainda melhora a capacidade do GPT-5 de aproveitar todas as ferramentas e contextos aos quais tem acesso.

Se você já usou o Claude Code com subagentes, sabe exatamente do que estou falando. De certa forma, todo esse sistema RAG agente de suporte ao cliente foi construído com inspiração no Claude Code. Mas o melhor modelo para problemas além da programação é o GPT-5. Eu construí uma avaliação para validar isso, então não foi apenas uma análise superficial dos resultados. Eu abordei isso em mais detalhes para meus assinantes da academia aqui:

Além disso, descobri que o GPT-5-Codex funciona bem para esse fluxo de trabalho, mas ainda não é tão bom quanto o GPT-5. Também experimentei o GPT-5-mini e fiquei impressionado com sua eficácia nesse caso de uso. O Claude 4 é muito caro para isso, e o Gemini 2.5 Pro está longe de ser comparável ao GPT-5 (embora também produza resultados razoáveis). A maioria desses outros modelos carecia de consistência e às vezes chamava as ferramentas na ordem errada ou com parâmetros incorretos (faça suas avaliações de chamada de ferramentas para confirmar isso). Um pouco de ajuste no prompt do sistema poderia ajudar, mas o GPT-5 ainda é superior.

72,48K

Top

Classificação

Favoritos