المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

فضولي لمعرفة مدى جودة عمل SFT بالنسبة للتعلم في السياق.

تشعر ICL بالسحر الأسود - النموذج يلتقط حقا مجموعة من المعلومات الضمنية بكفاءة العينة البشرية.

إذا كان الضبط الدقيق يمكن أن يقترب من ذلك ، فربما يمكنك تجميع شيء يبدو وكأنه تعلم مستمر فوقه؟

إليك فكرة ساذجة: حلقة داخلية ، قم بعمل SFT في ملخصات الجلسة. الحلقة الخارجية ، الأفق الطويل RL حيث يتعين عليها الاستفادة من المهارات والمعرفة التي يجب أن تمر بين الجلسات. تتعامل الحلقة الخارجية بشكل أساسي مع SFT على أنها استدعاء أداة ، مما يحفز النموذج على تمرير أكبر قدر ممكن من المعلومات المهمة.

أشعر بالفضول لمعرفة ما إذا كان شيء ما يجمع تقنيات مثل هذه سيكون كافيا للتعلم المستمر ، أو ما إذا كنا بحاجة إلى نموذج جديد تماما.

قام بتقدير فيرمي ممتع مع ChatGPT للحصول على بعض الحدس حول هذا السؤال.

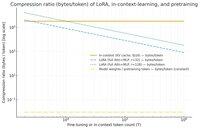

السؤال الذي يمكن أن تطرحه هو, إلى أي مدى يقوم SFT (عبر LoRA) بضغط المعلومات بالنسبة للتعلم في السياق? وقارنها بالتدريب المسبق من أجل المتعة فقط.

إذا كان هناك تباين كبير (ويعرف أيضا باسم هناك العديد من وحدات البايت المستخدمة لذاكرة التخزين المؤقت KV مقارنة بأوزان LoRA) ، فعندئذ * قد يشير * إلى أنه سيكون من الصعب جدا على LoRA أن يكون غنيا وفعالا في العينة و ICL.

مرة أخرى ، هذا هو حفرة أرنب بعد الظهر فائقة التموج ، وليست تحقيقا جادا. فقط لأنه يستخدم ذاكرة أقل لا يعني بالضرورة أنه أغبى بكثير ، وما إلى ذلك.

هذا الرسم البياني مخصص ل Llama 3 70 b (الذي تم تدريبه مسبقا على 15 تريليون رمز مميز).

بمجرد أن نصل إلى رقم واحد من آلاف الرموز المميزة ، يبدأ LoRA (الذي لا يتغير حجمه مع عدد الرموز المميزة التي تقوم بضبطها بدقة) في الضغط بشكل أكثر كثافة من ICL.

بمجرد حصولك على 100 ألف رمز مميز ، يتم ضغط الرموز المميزة التي تمر عبر المرتبة 32 LoRA 37 مرة أكثر مما لو كانت يتم الحضور فيها في السياق (عبر ذاكرة التخزين المؤقت KV).

ملاحظة جانبية: البايت لكل رمز تدريبي للتدريب المسبق منخفض بشكل لا يصدق! (0.009 في هذه الحالة).

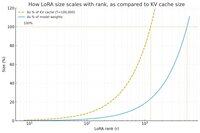

رفعل رسم بياني آخر, هذه المرة مع الحفاظ على عدد الرموز الثابتة عند 100k, وتغيير رتبة LoRA.

بسذاجة ، يبدو أن الرتبة يجب أن تكون صغيرة بما يكفي بحيث تكون جزءا صغيرا فقط من إجمالي أوزان النموذج (خلاف ذلك ، فلماذا تهتم ب LoRA؟) ، ولكنها أيضا كبيرة بما يكفي لاحتواء كمية كبيرة من المعلومات المخزنة في ذاكرة التخزين المؤقت KV. حتى تتمكن من معرفة أين قد تكون تلك البقعة الحلوة.

على أي حال ، هذه الرسوم البيانية ليست قاطعة لأي شيء. ويرجى العذر عن أي أخطاء أو سوء فهم محرج.

حرصا على الحصول على مستوى عال فعلي يأخذ مدى نجاح الجمع بين SFT و RL من حيث جعل التعلم المستمر الذي نراه من خلال العمل في التعلم في السياق بين الجلسات.

40.91K

الأفضل

المُتصدِّرة

التطبيقات المفضلة