トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SFTがコンテキスト学習と比較してどの程度うまく機能するか興味があります。

ICLは黒魔術のように感じられます - モデルは実際に人間のサンプル効率で暗黙の情報を大量に拾っています。

微調整がそれに近づくことができれば、その上で継続的な学習のように感じられるものをまとめることができるかもしれません。

素朴なアイデアは、インナーループで、セッションの要約でSFTを行うことです。外側のループ、長い地平線のRL、セッション間で通過しなければならないスキルと知識を活用する必要があります。外側のループは基本的に SFT をツール呼び出しとして扱い、モデルができるだけ多くの重要な情報を通過するように促します。

このような既存の技術を混ぜ合わせるものが継続的な学習に十分なのか、それともまったく新しいパラダイムが必要なのか興味があります。

この質問について直感を得るために、ChatGPTで楽しいフェルミ推定を行いました。

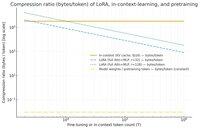

あなたが尋ねることができる質問は、SFT (LoRA 経由) はコンテキスト学習と比較して情報をどの程度圧縮するかということです。そして、それをただ楽しむための事前トレーニングと比較してください。

大きな格差がある場合(つまり、LoRAの重みと比較してKVキャッシュに使用されるバイト数が何倍も多い)、LoRAがリッチでサンプル効率が高く、ICLであることは非常に難しいことを示唆している可能性があります。

繰り返しになりますが、これは非常に手を振るう午後のウサギの穴であり、深刻な調査ではありません。使用するメモリがはるかに少ないからといって、必ずしもはるかに愚かであるというわけではありません。

このグラフは、Llama 3 70 b (15 兆トークンで事前トレーニングされた) 用です。

1桁の数千のトークンに達すると、LoRA(微調整するトークンの数によってサイズは変化しません)は、ICLよりもはるかに高密度に圧縮する必要があります。

100k トークンを取得すると、ランク 32 の LoRA を通過するトークンは、コンテキスト内で (KV キャッシュを介して) 処理されている場合よりも 37 倍圧縮されます。

補足:事前トレーニングのトレーニングトークンあたりのバイト数は信じられないほど少ないです。(この場合は0.009)。

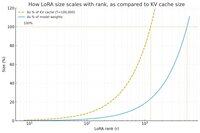

別のグラフを作成し、今回はトークン数を100kに一定に保ち、LoRAのランクを変更しました。

素朴なことに、ランクはモデルの重み全体のほんの一部にすぎないように十分に小さくする必要がありますが(そうでなければ、なぜわざわざLoRAを使用するのですか?)、KVキャッシュに保存されているかなりの量の情報を含めるのに十分な大きさであるように思われます。したがって、そのスイートスポットがどこにあるかがわかります。

とにかく、これらのグラフは何も決定的なものではありません。そして、恥ずかしい間違いや誤解があればご容赦ください。

SFTとRLを組み合わせることが、セッション間のコンテキスト内学習で見られる継続的な学習を機能させるという点で、実際に高レベルの見解を得ることに熱心です。

40.35K

トップ

ランキング

お気に入り