Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

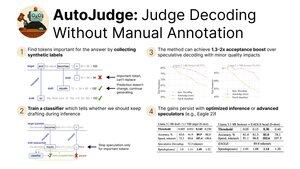

S radostí se podělíme o náš nedávný výzkum AutoJudge, dekódovací techniky, která kombinuje:

- Zrychlení inference uvolněním omezení shody rozdělení

- Snadnost použití a škálovatelnost díky samořízenému školicímu protokolu

Dnes prezentuji na #NeurIPS2025! (1/9)

Zjistili jsme, že můžeme automaticky těžit štítky pro klasifikátor přijetí. Konkrétně vezmeme datovou sadu a spustíme generace cílových a nakreslených modelů.

Poté kontrolujeme všechny nesouladné tokeny mezi cílovým a draftovým modelem. Pokud ponechání tokenu z draftového modelu vede k špatné odpovědi, je označen jako důležitý (3/9)

Pomocí těchto štítků můžeme natrénovat jednoduchý klasifikátor, který najde důležité tokeny v době inference.

Pokud by původní spekulativní dekódování token odmítlo, dáme mu druhou šanci tím, že se zeptáme klasifikátoru. U nedůležitých tokenů pokračujeme v generaci, ale u jiných zahajujeme nový spekulativní cyklus (9.4.)

Naše hlavní hodnocení AutoJudge se zaměřují na úkoly, u kterých je snadné změřit správnost odpovědí — programování (LiveCodeBench) a matematiku (GSM8K).

S páry modelů jako 8B/70B můžeme dosáhnout až 40 akceptovaných tokenů za cyklus s přesností <1 %! (5/9)

AutoJudge se také snadno integruje s open-source inferenčními frameworky, jako je vLLM. Zlepšení míry přijetí se promítá do zrychlení od začátku do konce: pokud obetujeme 2 % přesnosti, získáme téměř o 50 % více tokenů za sekundu! (6/9)

Kontrola anotací důležitých tokenů odhaluje zvláštní vzorec: jasné chyby jsou označeny jako záporné vzorky (=> je třeba regenerovat), zatímco sémanticky ekvivalentní tokeny umožňují spekulaci pokračovat (7/9)

Chcete-li se dozvědět více, podívejte se:

Papír:

Kód:

Blogový příspěvek:

Předpočítané aktivace pro GSM8K a LiveCodeBench:

(8/9)

Tuto práci vedli moji úžasní spoluautoři @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski a Vage Egiazarian.

Tým je tento týden v San Diegu na NeurIPS — přijďte se dnes pozdravit na posterové sezení!

16:30, plakát #2010 (9/9)

2,53K

Top

Hodnocení

Oblíbené