Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

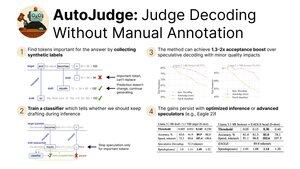

Emocionado de compartir nuestra investigación reciente sobre AutoJudge, una técnica de decodificación que combina:

- Aceleración de la inferencia mediante la relajación de la restricción de coincidencia de distribución

- Facilidad de uso y escalabilidad gracias a un protocolo de entrenamiento autosupervisado

¡Presento en #NeurIPS2025 hoy! (1/9)

Descubrimos que podemos extraer automáticamente las etiquetas para el clasificador de aceptación. Específicamente, tomamos un conjunto de datos y ejecutamos generaciones de modelos objetivo y borrador.

Luego, comprobamos todos los tokens que no coincidan entre los modelos objetivo y draft. Si mantener el token del modelo de borrador da como resultado incorrecto, se marca como importante (3/9)

Usando estas etiquetas, podemos entrenar un clasificador sencillo para encontrar tokens importantes en el momento de la inferencia.

Si la decodificación especulativa original rechazaría un token, le damos una segunda oportunidad preguntando al clasificador. Para tokens no importantes, continuamos la generación, pero para otros iniciamos un nuevo ciclo especulativo (9/4)

Nuestras principales evaluaciones de AutoJudge se centran en tareas para las que es fácil medir la corrección de respuestas — programación (LiveCodeBench) y matemáticas (GSM8K).

Con pares de modelos como 8B/70B, podemos lograr hasta 40 tokens aceptados por ciclo con un <1% de precisión de acerto. (5/9)

AutoJudge también se integra fácilmente con frameworks de inferencia de código abierto como vLLM. Las mejoras en la tasa de aceptación se traducen en aceleraciones de extremo a extremo: si intercambiamos un 2% de precisión, ¡obtenemos casi un 50% más de tokens por segundo! (6/9)

Al inspeccionar las anotaciones de los tokens importantes, se revela un patrón curioso: los errores claros se marcan como muestras negativas (=> necesidad de regenerar), mientras que los tokens semánticamente equivalentes permiten que la especulación avance (9/7)

Para saber más, consulta:

Papel:

Código:

Entrada del blog:

Activaciones precomputadas para GSM8K y LiveCodeBench:

(8/9)

Este trabajo estuvo dirigido por mis increíbles coautores @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski y Vage Egiazarian.

El equipo está en San Diego para NeurIPS esta semana — ¡ven hoy a saludar en la sesión de pósteres!

16:30, póster #2010 (9/9)

2.53K

Populares

Ranking

Favoritas