Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Le transfert de poids est l'un des plus grands goulets d'étranglement lors de l'exécution de l'apprentissage par renforcement distribué sur des modèles à haute capacité.

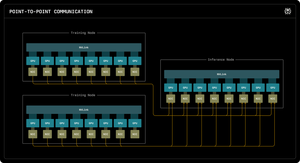

Notre premier blog de recherche Perplexity explique comment les ingénieurs en inférence de Perplexity ont exploité la communication point à point RDMA pour débloquer des mises à jour de paramètres ultra-rapides pour des modèles de trillions de paramètres.

En exploitant des primitives RDMA de bas niveau, une planification statique et le pipelining, nous accélérons les mises à jour d'un ordre de grandeur, à seulement 1,3 seconde par mise à jour.

Meilleurs

Classement

Favoris