热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

权重转移是执行高容量模型的分布式强化学习时最大的瓶颈之一。

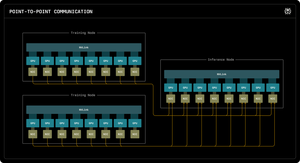

我们的第一篇 Perplexity Research 博客解释了 Perplexity 的推理工程师如何利用 RDMA 点对点通信来解锁万亿参数模型的超快速参数更新。

通过利用低级 RDMA 原语、静态调度和流水线,我们将更新加速了一个数量级,仅需 1.3 秒每次更新。

热门

排行

收藏