Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

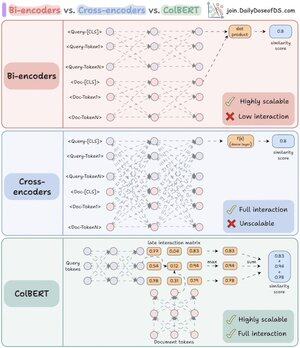

Ich habe endlich verstanden, warum Re-Ranker so mächtig sind, als ich den entscheidenden Unterschied zwischen Bi- und Cross-Encodern begriffen habe.

Ich habe außerdem einen Weg gefunden, ihre Kräfte mit einer einheitlichen Architektur zu kombinieren.

Lass mich erklären:

RAG besteht zu 80 % aus Abruf und zu 20 % aus Generierung. Wenn RAG also nicht funktioniert, liegt es höchstwahrscheinlich an einem Abrufproblem.

Genau deshalb ist es so wichtig, deine Abrufarchitektur richtig zu gestalten - und es beginnt mit dem Verständnis dieser beiden (eigentlich drei) Kodierungsansätze.

(Verweise auf die Visualisierung unten, während du liest)

1️⃣ Bi-Encoder

Bi-Encoder (das Rückgrat der Vektorsuche) verarbeiten Abfragen und Dokumente separat.

- Dokumenten-Embeddings werden vorab berechnet

- Abfrage wird zur Suchzeit eingebettet

Das macht Bi-Encoder perfekt für den ersten Abruf:

- extrem schnell

- funktioniert in großem Maßstab

- verpasst wichtige kontextuelle Informationen

2️⃣ Cross-Encoder

Cross-Encoder verfolgen einen völlig anderen Ansatz für das Re-Ranking.

Sie verarbeiten die Abfrage und jedes Dokument als eine Einheit.

- Kombiniere Abfrage mit Dokument ([CLS] Abfrage [SEP] Dokument [SEP])

- Durchlaufe das Modell gemeinsam für volle Kreuzaufmerksamkeit

Das macht Cross-Encoder ideal für die zweite Phase:

- erfasst semantische Beziehungen für bessere Genauigkeit

- aber viel langsamer und ressourcenintensiv für große Sammlungen

Was wäre, wenn wir das Beste aus beiden Welten kombinieren könnten!

3️⃣ ColBERT

ColBERT vereint die Kraft von Cross-Encodern und die Skalierbarkeit von Bi-Encodern.

- Kodiert Abfragen und Dokumente separat

- Erstellt eine Interaktionsmatrix mit Ähnlichkeitswerten zwischen allen Abfrage-Dokument-Token-Paaren

- Nimmt den Maximalwert für jedes Abfrage-Token über Dokument-Token

- Summiert die Maximalwerte für den endgültigen Übereinstimmungswert

_____

Das war's!

Wenn du es aufschlussreich fandest, teile es mit deinem Netzwerk.

Finde mich → @akshay_pachaar ✔️

Für weitere Einblicke und Tutorials zu LLMs, AI-Agenten und maschinellem Lernen!

46,67K

Top

Ranking

Favoriten