Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Proč modely předem netrénujeme pro agentické úlohy?

No, tihle kluci to udělali. A fungovalo to.

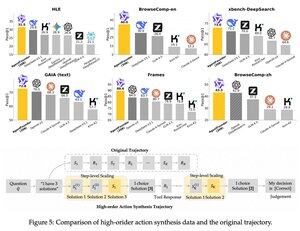

Zavedli mezikrok po předtréninku a před tréninkem. syntetizovali akční data agenta a jejich model AgentFounder-30B nastavuje novou SOTA na 10 benchmarků.

SFT má také výrazně menší ztrátu po tomto kroku Agentic Continual Pre-training.

Proč to funguje?

Protože univerzální základní modely obvykle nemají žádné agentní induktivní zkreslení, což staví Burdona na post-trénink.

Když zavedete vícestupňové uvažování a používání nástrojů v předtréninkové fázi, usnadníte cestu pro post-trénink, zvláště když to děláte se směsí agentických úkolů s krátkým a dlouhým horizontem.

Co to tedy znamená, pokud provozujete své podnikání na agentech nebo je budujete v jakémkoli měřítku?

Můžete syntetizovat data s nízkými náklady, dále předtrénovat základní model a poté jej následně vytrénovat.

Top

Hodnocení

Oblíbené