Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hvorfor trener vi ikke modeller på forhånd for agentiske oppgaver?

vel, disse gutta gjorde det. Og det fungerte.

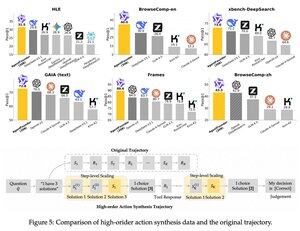

De introduserte et mellomtrinn etter fortreningen og før ettertreningen. de syntetiserte agenthandlingsdata og deres AgentFounder-30B-modell setter ny SOTA på 10 benchmarks.

SFT har også betydelig mindre tap etter dette Agentic Continual Pre-training-trinnet.

Hvorfor fungerer dette?

Fordi generelle grunnleggende modeller vanligvis ikke har noen agentisk induktiv skjevhet, setter burdon på ettertrening.

Når du introduserer resonnement i flere trinn og bruk av verktøy i fasen før opplæringen, gjør du det lettere for ettertrening, spesielt når du gjør det med en blanding av kort- og langsiktige agentoppgaver.

Så hva betyr dette hvis du driver virksomheten din på agenter eller bygger dem i hvilken som helst skala?

Du kan syntetisere data til lave kostnader, forhåndstrene en grunnleggende modell ytterligere og deretter ettertrene den.

Topp

Rangering

Favoritter