Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

¿Por qué no preentrenamos modelos para tareas agentivas?

Bueno, estos chicos lo hicieron. Y funcionó.

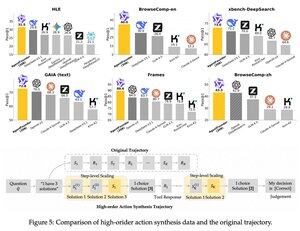

Introdujeron un paso intermedio después del preentrenamiento y antes del postentrenamiento. Sintetizaron datos de acción de agentes y su modelo AgentFounder-30B establece un nuevo SOTA en 10 benchmarks.

SFT también tiene una pérdida significativamente menor después de este paso de Preentrenamiento Continual Agentivo.

¿Por qué funciona esto?

Porque los modelos fundamentales de propósito general suelen no tener sesgo inductivo agentivo, lo que pone la carga en el postentrenamiento.

Cuando introduces razonamiento de múltiples pasos y uso de herramientas en la etapa de preentrenamiento, facilitas el camino para el postentrenamiento, especialmente cuando lo haces con una mezcla de tareas agentivas de corto y largo plazo.

Entonces, ¿qué significa esto si ejecutas tu negocio con agentes o los construyes a cualquier escala?

Puedes sintetizar datos a bajo costo, preentrenar aún más un modelo fundamental y luego postentrenarlo.

Parte superior

Clasificación

Favoritos