热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

为什么我们不为代理任务进行预训练模型?

好吧,这些家伙做到了。并且成功了。

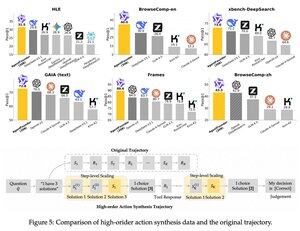

他们在预训练和后训练之间引入了一个中间步骤。他们合成了代理动作数据,他们的AgentFounder-30B模型在10个基准测试中设定了新的SOTA。

在这个代理持续预训练步骤之后,SFT的损失也显著更小。

这为什么有效?

因为通用基础模型通常没有代理归纳偏差,这将负担放在后训练上。

当你在预训练阶段引入多步骤推理和工具使用时,你为后训练铺平了道路,特别是当你用短期和长期代理任务的混合来做这件事时。

那么,如果你在代理上运营你的业务或以任何规模构建它们,这意味着什么?

你可以以低成本合成数据,进一步预训练一个基础模型,然后进行后训练。

热门

排行

收藏