Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

waarom trainen we modellen niet vooraf voor agentische taken?

nou, deze jongens deden dat. en het werkte.

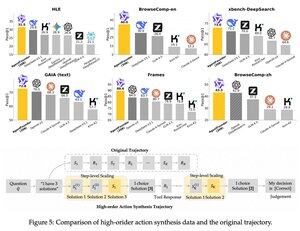

dezelfde introduceerden een tussenstap na de pre-training en voor de post-training. ze synthetiseerden agentactiegegevens en hun AgentFounder-30B model stelt een nieuwe SOTA vast op 10 benchmarks.

SFT heeft ook aanzienlijk kleinere verliezen na deze Agentic Continual Pre-training stap.

waarom werkt dit?

omdat algemene fundamentele modellen meestal geen agentische inductieve bias hebben, waardoor de last op de post-training komt.

wanneer je multi-stap redenering en het gebruik van tools in de pre-training fase introduceert, vergemakkelijk je de weg voor de post-training, vooral wanneer je dit doet met een mix van korte en lange horizon agentische taken.

wat betekent dit als je je bedrijf runt op agents of ze op enige schaal bouwt?

je kunt gegevens synthetiseren tegen lage kosten, een fundamenteel model verder pre-trainen en het vervolgens post-trainen.

Boven

Positie

Favorieten