熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

為什麼我們不為代理任務進行預訓練模型?

好吧,這些傢伙做到了。並且成功了。

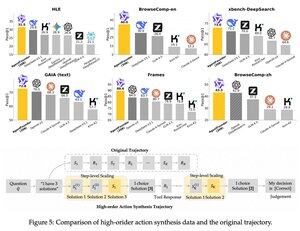

他們在預訓練和後訓練之間引入了一個中間步驟。他們合成了代理動作數據,他們的AgentFounder-30B模型在10個基準測試中設定了新的SOTA。

在這個代理持續預訓練步驟之後,SFT的損失也顯著更小。

這為什麼有效?

因為通用基礎模型通常沒有代理歸納偏差,這將負擔放在後訓練上。

當你在預訓練階段引入多步驟推理和工具使用時,你為後訓練鋪平了道路,特別是當你用短期和長期代理任務的混合來做這件事時。

那麼,如果你在代理上運營你的業務或以任何規模構建它們,這意味著什麼?

你可以以低成本合成數據,進一步預訓練一個基礎模型,然後進行後訓練。

熱門

排行

收藏