Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

perché non pre-addestriamo modelli per compiti agentici?

beh, questi ragazzi l'hanno fatto. e ha funzionato.

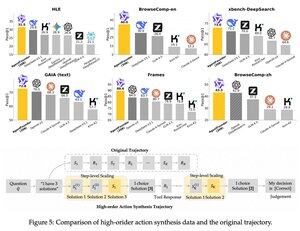

hanno introdotto un passaggio intermedio dopo il pre-addestramento e prima del post-addestramento. hanno sintetizzato dati sulle azioni degli agenti e il loro modello AgentFounder-30B stabilisce un nuovo SOTA su 10 benchmark.

SFT ha anche una perdita significativamente più piccola dopo questo passaggio di Pre-addestramento Continuale Agentico.

perché funziona?

perché i modelli fondamentali di uso generale di solito non hanno un bias induttivo agentico, ponendo il peso sul post-addestramento.

quando introduci il ragionamento a più passaggi e l'uso di strumenti nella fase di pre-addestramento, faciliti il percorso per il post-addestramento, specialmente quando lo fai con una miscela di compiti agentici a breve e lungo termine.

quindi, cosa significa questo se gestisci la tua attività con agenti o li costruisci su qualsiasi scala?

puoi sintetizzare dati a basso costo, ulteriormente pre-addestrare un modello fondamentale e poi post-addestrarlo.

Principali

Ranking

Preferiti