Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Varför tränar vi inte modeller i förväg för agentiska uppgifter?

Jo de här killarna gjorde. Och det fungerade.

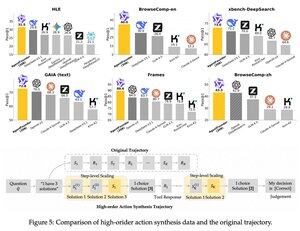

De införde ett mellansteg efter förträningen och före efter träningen. de syntetiserade data om agentåtgärder och deras AgentFounder-30B-modell sätter nya SOTA på 10 riktmärken.

SFT har också betydligt mindre förlust efter detta Agentic Continual Pre-training steg.

Varför fungerar det här?

Eftersom allmänna grundläggande modeller vanligtvis inte har någon agentisk induktiv bias, vilket sätter Burdon på efterträning.

När du introducerar resonemang i flera steg och användning av verktyg i förträningsstadiet underlättar du vägen för efterträningen, särskilt när du gör det med en blandning av agentiska uppgifter med kort och lång horisont.

Så vad betyder detta om du driver ditt företag på agenter eller bygger dem i någon skala?

Du kan syntetisera data till låg kostnad, ytterligare förträna en grundläggande modell och sedan efterträna den.

Topp

Rankning

Favoriter