Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

pourquoi ne pré-entraînons-nous pas des modèles pour des tâches agentiques ?

eh bien, ces gars-là l'ont fait. et ça a fonctionné.

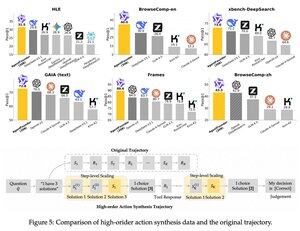

ils ont introduit une étape intermédiaire après le pré-entraînement et avant le post-entraînement. ils ont synthétisé des données d'action d'agent et leur modèle AgentFounder-30B établit un nouveau SOTA sur 10 benchmarks.

SFT a également une perte significativement plus faible après cette étape de Pré-entraînement Agentique Continu.

pourquoi cela fonctionne-t-il ?

parce que les modèles fondamentaux à usage général n'ont généralement pas de biais inductif agentique, ce qui met le fardeau sur le post-entraînement.

lorsque vous introduisez un raisonnement multi-étapes et l'utilisation d'outils dans la phase de pré-entraînement, vous facilitez le post-entraînement, surtout lorsque vous le faites avec un mélange de tâches agentiques à court et à long terme.

alors que signifie cela si vous gérez votre entreprise avec des agents ou si vous les construisez à n'importe quelle échelle ?

vous pouvez synthétiser des données à faible coût, pré-entraîner davantage un modèle fondamental et ensuite le post-entraîner.

Meilleurs

Classement

Favoris