Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

por que não pré-treinamos modelos para tarefas agentivas?

bem, esses caras fizeram. e funcionou.

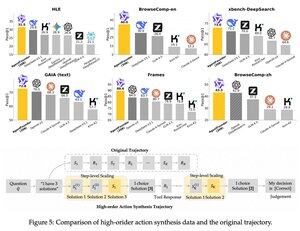

eles introduziram uma etapa intermediária após o pré-treinamento e antes do pós-treinamento. eles sintetizaram dados de ação de agentes e seu modelo AgentFounder-30B estabelece um novo SOTA em 10 benchmarks.

O SFT também tem uma perda significativamente menor após esta etapa de Pré-treinamento Contínuo Agentivo.

por que isso funciona?

porque modelos fundacionais de propósito geral geralmente não têm viés indutivo agentivo, colocando o fardo no pós-treinamento.

quando você introduz raciocínio de múltiplas etapas e uso de ferramentas na fase de pré-treinamento, você facilita o caminho para o pós-treinamento, especialmente quando você faz isso com uma mistura de tarefas agentivas de curto e longo prazo.

então, o que isso significa se você administrar seu negócio com agentes ou construí-los em qualquer escala?

você pode sintetizar dados a baixo custo, pré-treinar ainda mais um modelo fundacional e, em seguida, pós-treiná-lo.

Top

Classificação

Favoritos