Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman & Thinking Machines: LoRA bez lítosti

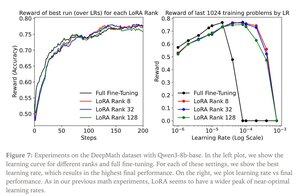

LoRA nahrazuje každou váhovou matici W z původního modelu upravenou verzí W'=W+γBAW'=W+γBA, kde B a A jsou matice, které mají dohromady mnohem méně parametrů než W.

LoRA funguje podobně jako úplné doladění, když:

1. LoRA je aplikována na všechny vrstvy sítě, zejména na vrstvy MLP/MoE, které obsahují většinu parametrů.

2. LoRA není omezena kapacitou, tj. počet trénovatelných parametrů překračuje množství informací, které je třeba se naučit, což lze odhadnout z hlediska velikosti datové sady.

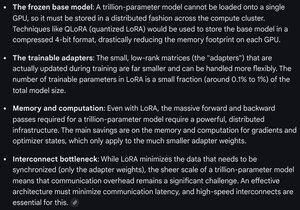

Důsledky: Velké (např. biliony parametrů) základní modely lze přizpůsobit za zlomek nákladů na trénování nového modelu.

Příspěvek Thinking Machines:

Gemini o výpočetních požadavcích pro LoRA na hraničním modelu - stále impozantní, ale počet použitých parametrů je menší než 1 % celkové velikosti modelu (předtrénování).

4,29K

Top

Hodnocení

Oblíbené