Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman e Máquinas de Pensar: LoRA Sem Arrependimento

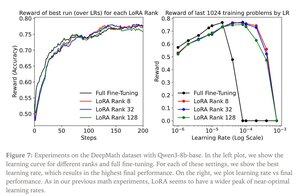

LoRA substitui cada matriz de peso W do modelo original por uma versão modificada W'=W+γBAW'=W+γBA, onde B e A são matrizes que juntas têm muito menos parâmetros que W.

O LoRA funciona de forma semelhante ao ajuste fino completo quando:

1. LoRA é aplicado a todas as camadas da rede, especialmente as camadas MLP/MoE que abrigam a maioria dos parâmetros.

2. LoRA não tem capacidade restrita, ou seja, o número de parâmetros treináveis excede a quantidade de informações a serem aprendidas, que podem ser estimadas em termos de tamanho do conjunto de dados.

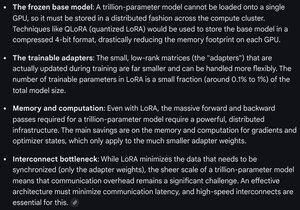

Implicações: Modelos básicos grandes (por exemplo, trilhões de parâmetros) podem ser personalizados por uma fração do custo de treinamento de um novo modelo.

Máquinas de pensar postar:

Gemini sobre os requisitos de computação para LoRA em um modelo de fronteira - ainda formidável, mas o número de parâmetros usados é inferior a 1% do tamanho total do modelo (pré-treinamento).

8,67K

Melhores

Classificação

Favoritos