Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Джон Шульман і мислячі машини: LoRA без жалю

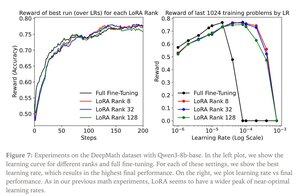

LoRA замінює кожну вагову матрицю W з оригінальної моделі модифікованою версією W'=W+γBAW'=W+γBA, де B і A — матриці, які разом мають набагато менше параметрів, ніж W.

LoRA виконує подібно до повного тонкого налаштування, коли:

1. LoRA застосовується до всіх рівнів мережі, особливо до шарів MLP/MoE, на яких розміщено більшість параметрів.

2. LoRA не обмежена можливостями, тобто кількість параметрів, що тренуються, перевищує обсяг інформації, що підлягає вивченню, який можна оцінити в термінах розміру набору даних.

Наслідки: Великі (наприклад, трильйон параметрів) базові моделі можуть бути налаштовані за невелику частку вартості навчання нової моделі.

Допис «Мислячі машини»:

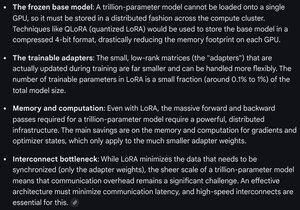

Gemini про вимоги до обчислень для LoRA на frontier моделі - все ще величезна, але кількість використовуваних параметрів становить менше 1% від загального розміру моделі (попереднє навчання).

4,33K

Найкращі

Рейтинг

Вибране