Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman ja Thinking Machines: LoRA ilman katumusta

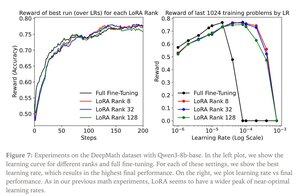

LoRA korvaa jokaisen alkuperäisen mallin painomatriisin W muokatulla versiolla W'=W+γBAW'=W+γBA, jossa B ja A ovat matriiseja, joilla on yhdessä paljon vähemmän parametreja kuin W:llä.

LoRA toimii samalla tavalla kuin täysi hienosäätö, kun:

1. LoRA:ta sovelletaan kaikkiin verkon kerroksiin, erityisesti MLP/MoE-kerroksiin, joissa on suurin osa parametreista.

2. LoRA ei ole kapasiteettirajoitteinen, eli koulutettavien parametrien määrä ylittää opittavan tiedon määrän, joka voidaan arvioida aineiston koon perusteella.

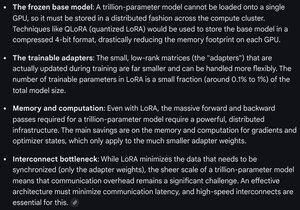

Vaikutukset: Suuria (esim. biljoonan parametrin) perusmalleja voidaan räätälöidä murto-osalla uuden mallin koulutuskustannuksista.

Thinking Machines -viesti:

Gemini LoRA:n laskentavaatimuksista rajamallissa - edelleen mahtava, mutta käytettyjen parametrien määrä on alle 1 % mallin kokonaiskoosta (esikoulutus).

8,67K

Johtavat

Rankkaus

Suosikit