Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman și mașinile de gândire: LoRA fără regrete

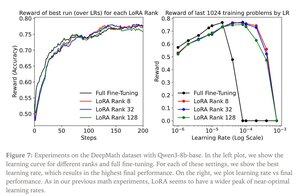

LoRA înlocuiește fiecare matrice de greutate W din modelul original cu o versiune modificată W'=W+γBAW'=W+γBA, unde B și A sunt matrice care împreună au mult mai puțini parametri decât W.

LoRA funcționează similar cu reglarea fină completă atunci când:

1. LoRA se aplică tuturor straturilor rețelei, în special straturilor MLP/MoE care găzduiesc majoritatea parametrilor.

2. LoRA nu este limitat de capacitate, adică numărul de parametri antrenabili depășește cantitatea de informații care trebuie învățate, care poate fi estimată în termeni de dimensiune a setului de date.

Implicații: Modelele de bază mari (de exemplu, trilioane de parametri) pot fi personalizate la o fracțiune din costul antrenării unui nou model.

Postarea Thinking Machines:

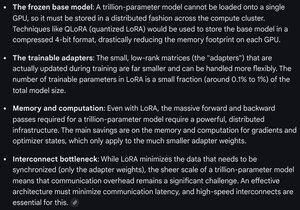

Gemini despre cerințele de calcul pentru LoRA pe un model de frontieră - încă formidabil, dar numărul de parametri utilizați este mai mic de 1% din dimensiunea totală a modelului (pretraining).

4,33K

Limită superioară

Clasament

Favorite