Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman e Thinking Machines: LoRA senza rimpianti

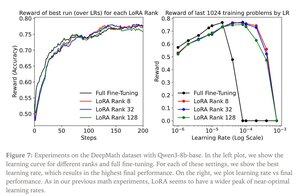

LoRA sostituisce ogni matrice di pesi W del modello originale con una versione modificata W’=W+γBAW’=W+γBA, dove B e A sono matrici che insieme hanno un numero di parametri molto inferiore rispetto a W.

LoRA si comporta in modo simile al fine-tuning completo quando:

1. LoRA è applicata a tutti i livelli della rete, specialmente i livelli MLP/MoE che ospitano la maggior parte dei parametri.

2. LoRA non è limitata in capacità, cioè, il numero di parametri addestrabili supera la quantità di informazioni da apprendere, che può essere stimata in termini di dimensione del dataset.

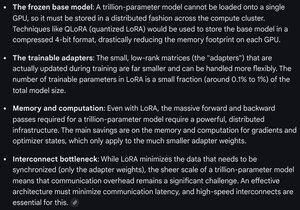

Implicazioni: Modelli base di grandi dimensioni (ad esempio, trilioni di parametri) possono essere personalizzati a una frazione del costo di addestrare un nuovo modello.

Post di Thinking Machines:

Gemini sui requisiti di calcolo per LoRA su un modello frontier - ancora formidabili, ma il numero di parametri utilizzati è inferiore all'1% della dimensione totale del modello (preaddestramento).

7,93K

Principali

Ranking

Preferiti