Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman & Thinking Machines: LoRA Zonder Spijt

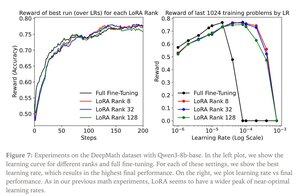

LoRA vervangt elke gewichtsmatrix W van het originele model door een gewijzigde versie W’=W+γBAW’=W+γBA, waarbij B en A matrices zijn die samen veel minder parameters hebben dan W.

LoRA presteert vergelijkbaar met volledige fine-tuning wanneer:

1. LoRA wordt toegepast op alle lagen van het netwerk, vooral de MLP/MoE-lagen waarin de meeste parameters zich bevinden.

2. LoRA niet beperkt is in capaciteit, d.w.z. het aantal trainbare parameters overschrijdt de hoeveelheid informatie die geleerd moet worden, wat kan worden geschat in termen van datasetgrootte.

Gevolgen: Grote (bijv. triljoen parameter) basismodellen kunnen worden aangepast voor een fractie van de kosten van het trainen van een nieuw model.

Thinking Machines post:

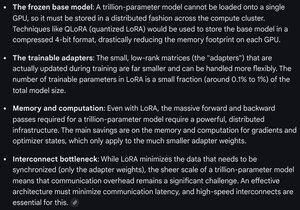

Gemini over de rekenvereisten voor LoRA op een frontier model - nog steeds formidabel, maar het aantal gebruikte parameters is minder dan 1% van de totale modelgrootte (voortraining).

4,32K

Boven

Positie

Favorieten