Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman og Thinking Machines: LoRA uten anger

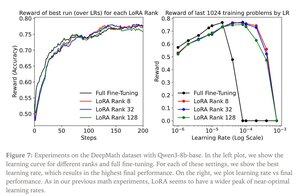

LoRA erstatter hver vektmatrise W fra den opprinnelige modellen med en modifisert versjon W'=W+γBAW'=W+γBA, der B og A er matriser som til sammen har langt færre parametere enn W.

LoRA fungerer på samme måte som full finjustering når:

1. LoRA brukes på alle lag i nettverket, spesielt MLP/MoE-lagene som inneholder de fleste parameterne.

2. LoRA er ikke kapasitetsbegrenset, det vil si antall trenbare parametere overstiger mengden informasjon som skal læres, som kan estimeres i form av datasettstørrelse.

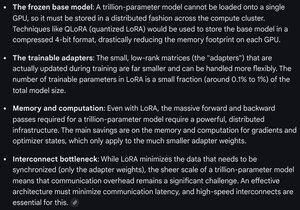

Implikasjoner: Store (f.eks. billioner parametere) basismodeller kan tilpasses til en brøkdel av kostnaden for å trene en ny modell.

Thinking Machines-innlegg:

Gemini om beregningskravene for LoRA på en frontier-modell - fortsatt formidabel, men antall parametere som brukes er mindre enn 1 % av total modellstørrelse (pretraining).

4,31K

Topp

Rangering

Favoritter