Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman & Thinking Machines: LoRA ohne Bedauern

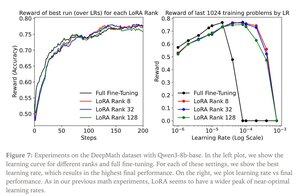

LoRA ersetzt jede Gewichtsmatrix W des ursprünglichen Modells durch eine modifizierte Version W’=W+γBAW’=W+γBA, wobei B und A Matrizen sind, die zusammen deutlich weniger Parameter als W haben.

LoRA funktioniert ähnlich wie das vollständige Fine-Tuning, wenn:

1. LoRA auf alle Schichten des Netzwerks angewendet wird, insbesondere auf die MLP/MoE-Schichten, die die meisten Parameter enthalten.

2. LoRA nicht kapazitätsbeschränkt ist, d.h. die Anzahl der trainierbaren Parameter die Menge an Informationen übersteigt, die gelernt werden soll, was in Bezug auf die Datensatzgröße geschätzt werden kann.

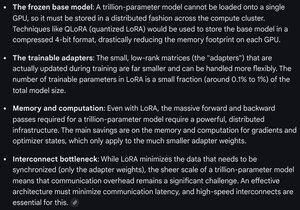

Implikationen: Große (z.B. Billionen-Parameter) Basismodelle können zu einem Bruchteil der Kosten eines neuen Modells angepasst werden.

Thinking Machines Beitrag:

Gemini zu den Rechenanforderungen für LoRA bei einem Frontier-Modell - immer noch gewaltig, aber die Anzahl der verwendeten Parameter beträgt weniger als 1 % der gesamten Modellgröße (Vortraining).

4,33K

Top

Ranking

Favoriten