トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ジョン・シュルマン & シンキング・マシーンズ: 後悔のない LoRA

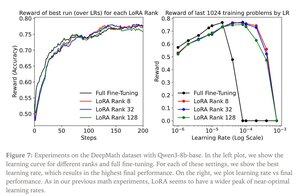

LoRAは、元のモデルの各重み行列Wを、修正バージョンのW'=W+γBAW'=W+γBAに置き換えます。ここで、BとAは、Wよりもはるかに少ないパラメータを持つ行列です。

LoRAは、次の場合に完全な微調整と同様に機能します。

1. LoRAは、ネットワークのすべての層、特にほとんどのパラメータを格納するMLP / MoE層に適用されます。

2. LoRAは容量に制約がなく、学習可能なパラメータの数が学習する情報量を超えており、データセットのサイズで推定できます。

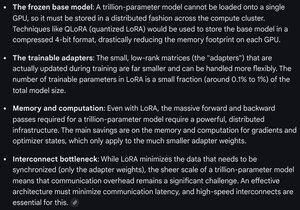

含意: 大規模な (たとえば、1 兆のパラメーター) ベース モデルは、新しいモデルのトレーニングのコストの数分の一でカスタマイズできます。

Thinking Machines の投稿:

フロンティアモデルでのLoRAの計算要件に関するGemini - まだ手ごわいですが、使用されるパラメーターの数はモデル全体のサイズ(事前トレーニング)の1%未満です。

4.33K

トップ

ランキング

お気に入り