Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Wir haben gerade herausgefunden, wie man ONE TRILLION Parameter in 1,3 Sekunden zwischen GPUs überträgt.

Das ist eine 20-fache Beschleunigung im Vergleich zu traditionellen Methoden.

Lass mich dir zeigen, wie wir das gemacht haben:

Vor 10 Stunden

Der Gewichtstransfer ist eines der größten Engpässe bei der Durchführung von verteiltem RL auf Modellen mit hoher Kapazität.

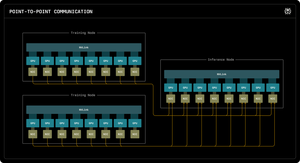

Unser erster Perplexity Research Blog erklärt, wie die Inferenzingenieure von Perplexity RDMA-Punkt-zu-Punkt-Kommunikation genutzt haben, um ultraschnelle Parameteraktualisierungen für Billionen-Parameter-Modelle freizuschalten.

Durch die Nutzung von Low-Level-RDMA-Primitiven, statischer Planung und Pipeline-Verarbeitung beschleunigen wir die Aktualisierungen um das Zehnfache, auf nur 1,3 Sekunden pro Aktualisierung.

1/ Das Problem

Beim Training massiver KI-Modelle mit verstärkendem Lernen benötigt man zwei separate GPU-Cluster, die zusammenarbeiten: Trainings-GPUs, die das Modell aktualisieren, und Inferenz-GPUs, die es ausführen.

Nach jedem Trainingsschritt müssen alle aktualisierten Gewichte von Training zu Inferenz kopiert werden. Bei Modellen mit Billionen von Parametern benötigen die meisten Systeme 30 Sekunden bis mehrere MINUTEN dafür.

Das ist ein massiver Engpass. Ihr Trainingsschritt könnte 5 Sekunden dauern, aber dann warten Sie 30 Sekunden nur, um Gewichte zu kopieren.

1/ Das Problem

Wenn wir massive KI-Modelle mit verstärkendem Lernen trainieren, benötigen wir zwei separate GPU-Cluster, die zusammenarbeiten: Trainings-GPUs, die das Modell aktualisieren, und Inferenz-GPUs, die es ausführen.

Nach jedem Trainingsschritt müssen wir all diese aktualisierten Gewichte von Training zu Inferenz kopieren. Für unser Billionen-Parameter Kimi-K2-Modell benötigen die meisten bestehenden Systeme 30 Sekunden bis mehrere MINUTEN, um dies zu tun.

Das ist ein massiver Engpass.

Unser Trainingsschritt könnte 5 Sekunden dauern, aber dann würden wir 30 Sekunden nur mit dem Kopieren von Gewichten warten. Unakzeptabel.

2/ Der alte Weg

Traditionelle Systeme leiten alles über eine „Rank-0“-GPU. Alle Trainings-GPUs senden an eine Haupt-GPU, die an eine Inferenz-GPU sendet, die an den Rest verteilt.

Es ist, als würde man alle Post durch ein einziges Postamt leiten. Diese eine Verbindung wird zum Engpass - begrenzt auf etwa 50 Gigabyte pro Sekunde.

Wir wussten, dass es einen besseren Weg geben musste.

3/ Unser Durchbruch

Unsere Lösung: RDMA WRITE - Remote Direct Memory Access.

Mit RDMA können unsere Trainings-GPUs direkt in den Speicher der Inferenz-GPUs schreiben. Kein Mittelsmann. Keine Erlaubnis einholen. Wir teleportieren Daten direkt in den RAM eines anderen Computers.

Die empfangende GPU wird nicht einmal benachrichtigt. Es ist eine "einseitige" Operation.

Und hier ist der Schlüssel: JEDER Trainings-GPU kommuniziert direkt mit JEDER Inferenz-GPU. Alle auf einmal. Parallel. Wir saturieren das gesamte Netzwerkgewebe, anstatt an einem einzelnen Link zu flaschenhalsen.

Wir verwenden auch Pipelining - wir unterteilen Übertragungen in überlappende Phasen, damit verschiedene Hardware-Ressourcen gleichzeitig beschäftigt bleiben.

Außerdem berechnen wir den Übertragungszeitplan einmal beim Start und spielen ihn einfach ab. Keine wiederholte Planungsüberlastung.

4/ Unsere Ergebnisse

Für Kimi-K2 mit 1 Billion Parametern: 1,3 Sekunden für den Transfer von 256 Trainings-GPUs zu 128 Inferenz-GPUs.

Das sind etwa 2 Terabyte Daten in etwas über einer Sekunde. Über ein Netzwerk. Zwischen Maschinen.

Wenn wir Tausende von Dollar pro Stunde für GPU-Cluster ausgeben, bedeutet die Beseitigung dieses Engpasses massive Kosteneinsparungen und schnellere Iterationszyklen.

4/ Unsere Ergebnisse

Für Kimi-K2 mit 1 Billion Parametern: 1,3 Sekunden für den Transfer von 256 Trainings-GPUs zu 128 Inferenz-GPUs.

Das sind etwa 2 Terabyte Daten in etwas über einer Sekunde. Über ein Netzwerk. Zwischen Maschinen.

Wenn wir Tausende von Dollar pro Stunde für GPU-Cluster ausgeben, bedeutet die Beseitigung dieses Engpasses massive Kosteneinsparungen und schnellere Iterationszyklen.

5/ Warum es wichtig ist

Der elegante Teil? Wir haben keine neue Hardware erfunden. Wir haben einfach bestehende RDMA-Technologie mit intelligenter Systemtechnik genutzt.

Manchmal geht es bei den besten Lösungen nicht darum, etwas Neues zu erfinden - es geht darum, bestehende Werkzeuge wirklich, wirklich gut zu nutzen.

So bauen wir bei Perplexity.

Das ist also der Überblick über unser Gewichtstransfersystem. Aber ich bin mir sicher, dass ihr alle Fragen habt, oder?

Fragt mich alles.

74,63K

Top

Ranking

Favoriten