Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kami baru saja menemukan cara mentransfer SATU TRILIUN parameter antar GPU dalam 1,3 detik.

Itu adalah percepatan 20x lipat dari metode tradisional.

Izinkan saya menunjukkan kepada Anda bagaimana kami melakukannya:

17 jam lalu

Transfer berat adalah salah satu hambatan terbesar saat melakukan RL terdistribusi pada model berkapasitas tinggi.

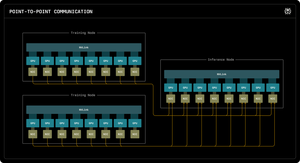

Blog Perplexity Research pertama kami menjelaskan bagaimana insinyur inferensi Perplexity memanfaatkan komunikasi point-to-point RDMA untuk membuka pembaruan parameter ultra-cepat untuk model triliunan parameter.

Dengan memanfaatkan primitif RDMA tingkat rendah, penjadwalan statis, dan pipelining, kami mempercepat pembaruan dengan urutan besarnya, menjadi hanya 1,3 detik per pembaruan.

1/ Masalah

Saat melatih model AI besar-besaran dengan pembelajaran penguatan, Anda memerlukan dua kluster GPU terpisah yang bekerja bersama: GPU pelatihan yang memperbarui model, dan GPU inferensi yang menjalankannya.

Setelah setiap langkah pelatihan, Anda harus menyalin semua bobot yang diperbarui dari latihan hingga inferensi. Untuk model triliunan parameter, sebagian besar sistem membutuhkan waktu 30 detik hingga beberapa MENIT untuk melakukan ini.

Itu adalah kemacetan besar. Langkah latihan Anda mungkin memakan waktu 5 detik, tetapi kemudian Anda menunggu 30 detik hanya dengan menyalin beban.

1/ Masalah

Saat kami melatih model AI besar-besaran dengan pembelajaran penguatan, kami memerlukan dua kluster GPU terpisah yang bekerja bersama: GPU pelatihan yang memperbarui model, dan GPU inferensi yang menjalankannya.

Setelah setiap langkah pelatihan, kita harus menyalin semua bobot yang diperbarui dari latihan ke kesimpulan. Untuk model Kimi-K2 triliunan parameter kami, sebagian besar sistem yang ada membutuhkan waktu 30 detik hingga beberapa MENIT untuk melakukan ini.

Itu adalah kemacetan besar.

Langkah latihan kami mungkin memakan waktu 5 detik, tetapi kemudian kami akan menunggu 30 detik hanya untuk menyalin bobot. Diterima.

2/ Cara Lama

Sistem tradisional menyalurkan semuanya melalui satu GPU "peringkat-0". Semua GPU pelatihan dikirim ke satu GPU utama, yang dikirim ke satu GPU inferensi, yang mendistribusikan ke yang lain.

Ini seperti memaksa semua surat untuk melewati satu kantor pos. Satu koneksi itu menjadi hambatan - terbatas hingga sekitar 50 gigabyte per detik.

Kami tahu harus ada cara yang lebih baik.

3/ Terobosan Kami

Solusi kami: RDMA WRITE - Akses Memori Langsung Jarak Jauh.

Dengan RDMA, GPU pelatihan kami dapat langsung menulis ke dalam memori GPU inferensi. Tidak ada perantara. Tidak ada izin yang diminta. Kami hanya memindahkan data langsung ke RAM komputer lain.

GPU penerima bahkan tidak diberi tahu. Ini adalah operasi "sepihak".

Dan inilah kuncinya: SETIAP GPU pelatihan berbicara langsung ke SETIAP GPU inferensi. Sekaligus. Secara paralel. Kami menjenuhkan seluruh struktur jaringan alih-alih kemacetan pada satu tautan.

Kami juga menggunakan pipelining - memecah transfer menjadi tahapan yang tumpang tindih sehingga sumber daya perangkat keras yang berbeda tetap sibuk secara bersamaan.

Plus, kami menghitung jadwal transfer sekali saat startup dan hanya memutarnya ulang. Tidak ada overhead perencanaan berulang.

4/ Hasil Kami

Untuk Kimi-K2 dengan 1 triliun parameter: 1,3 detik untuk mentransfer dari 256 GPU pelatihan ke 128 GPU inferensi.

Itu memindahkan sekitar 2 terabyte data hanya dalam waktu satu detik. Melalui jaringan. Antar mesin.

Ketika kita membakar ribuan dolar per jam pada kluster GPU, menghilangkan kemacetan ini berarti penghematan biaya besar-besaran dan siklus iterasi yang lebih cepat.

4/ Hasil Kami

Untuk Kimi-K2 dengan 1 triliun parameter: 1,3 detik untuk mentransfer dari 256 GPU pelatihan ke 128 GPU inferensi.

Itu memindahkan sekitar 2 terabyte data hanya dalam waktu satu detik. Melalui jaringan. Antar mesin.

Ketika kita membakar ribuan dolar per jam pada kluster GPU, menghilangkan kemacetan ini berarti penghematan biaya besar-besaran dan siklus iterasi yang lebih cepat.

5/ Mengapa Itu Penting

Bagian yang elegan? Kami tidak menemukan perangkat keras baru. Kami baru saja menggunakan teknologi RDMA yang ada dengan rekayasa sistem pintar.

Terkadang solusi terbaik bukan tentang menciptakan sesuatu yang baru - ini tentang menggunakan alat yang ada dengan sangat, sangat baik.

Begitulah cara kami membangun di Perplexity.

Jadi itulah ikhtisar tingkat tinggi dari sistem transfer berat badan kami. Tapi saya yakin Anda semua memiliki pertanyaan, bukan?

Tanyakan apa saja.

87,3K

Teratas

Peringkat

Favorit