Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Właśnie odkryliśmy, jak przesłać JEDEN TRYLION parametrów między GPU w 1,3 sekundy.

To 20-krotne przyspieszenie w porównaniu do tradycyjnych metod.

Pozwól, że pokażę ci, jak to zrobiliśmy:

10 godz. temu

Transfer wag jest jednym z największych wąskich gardeł podczas wykonywania rozproszonego RL na modelach o dużej pojemności.

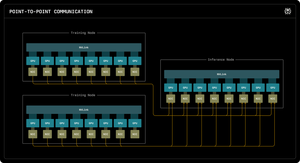

Nasz pierwszy blog badawczy Perplexity wyjaśnia, jak inżynierowie ds. wnioskowania Perplexity wykorzystali komunikację RDMA punkt-punkt, aby odblokować ultra-szybkie aktualizacje parametrów dla modeli z trylionem parametrów.

Wykorzystując niskopoziomowe prymitywy RDMA, statyczne planowanie i potokowanie, przyspieszamy aktualizacje o rząd wielkości, do zaledwie 1,3 sekundy na aktualizację.

1/ Problem

Podczas trenowania ogromnych modeli AI z wykorzystaniem uczenia przez wzmocnienie, potrzebujesz dwóch oddzielnych klastrów GPU współpracujących ze sobą: GPU do trenowania, które aktualizują model, oraz GPU do wnioskowania, które go uruchamiają.

Po każdym kroku treningowym musisz skopiować wszystkie zaktualizowane wagi z treningu do wnioskowania. W przypadku modeli z trylionem parametrów, większość systemów potrzebuje od 30 sekund do kilku MINUT, aby to zrobić.

To ogromne wąskie gardło. Twój krok treningowy może trwać 5 sekund, ale potem czekasz 30 sekund tylko na skopiowanie wag.

1/ Problem

Kiedy trenujemy ogromne modele AI za pomocą uczenia przez wzmocnienie, potrzebujemy dwóch oddzielnych klastrów GPU współpracujących ze sobą: GPU do treningu, które aktualizują model, oraz GPU do wnioskowania, które go uruchamiają.

Po każdym kroku treningowym musimy skopiować wszystkie zaktualizowane wagi z treningu do wnioskowania. Dla naszego modelu Kimi-K2 z trylionem parametrów, większość istniejących systemów zajmuje od 30 sekund do kilku MINUT, aby to zrobić.

To ogromne wąskie gardło.

Nasz krok treningowy może zająć 5 sekund, ale potem czekamy 30 sekund tylko na skopiowanie wag. Nieakceptowalne.

2/ Stary sposób

Tradycyjne systemy kierują wszystko przez jeden „GPU rangi 0”. Wszystkie GPU do treningu wysyłają dane do jednego głównego GPU, które przesyła je do jednego GPU do wnioskowania, które rozdziela je do reszty.

To tak, jakby zmuszać całą pocztę do przechodzenia przez jeden jedyny urząd pocztowy. To jedno połączenie staje się wąskim gardłem - ograniczone do około 50 gigabajtów na sekundę.

Wiedzieliśmy, że musi być lepszy sposób.

3/ Nasze przełomowe rozwiązanie

Nasze rozwiązanie: RDMA WRITE - Zdalny Bezpośredni Dostęp do Pamięci.

Dzięki RDMA nasze GPU do treningu mogą bezpośrednio zapisywać dane do pamięci GPU do wnioskowania. Bez pośredników. Bez pytania o pozwolenie. Po prostu teleportujemy dane bezpośrednio do pamięci RAM innego komputera.

Odbierające GPU nawet nie zostaje powiadomione. To operacja „jednostronna”.

A oto klucz: KAŻDE GPU do treningu rozmawia bezpośrednio z KAŻDYM GPU do wnioskowania. Wszystkie jednocześnie. Równolegle. Saturujemy całą sieć zamiast ograniczać się do jednego łącza.

Używamy również pipeliningu - dzieląc transfery na nakładające się etapy, aby różne zasoby sprzętowe były zajęte jednocześnie.

Dodatkowo, obliczamy harmonogram transferu raz przy uruchomieniu i po prostu go odtwarzamy. Brak powtarzających się kosztów planowania.

4/ Nasze wyniki

Dla Kimi-K2 z 1 trylionem parametrów: 1,3 sekundy na transfer z 256 GPU do 128 GPU do wnioskowania.

To przenoszenie około 2 terabajtów danych w nieco ponad sekundę. Przez sieć. Między maszynami.

Kiedy wydajemy tysiące dolarów na godzinę na klastry GPU, eliminacja tego wąskiego gardła oznacza ogromne oszczędności kosztów i szybsze cykle iteracyjne.

4/ Nasze wyniki

Dla Kimi-K2 z 1 trylionem parametrów: 1,3 sekundy na transfer z 256 GPU do 128 GPU do wnioskowania.

To przenoszenie około 2 terabajtów danych w nieco ponad sekundę. Przez sieć. Między maszynami.

Kiedy wydajemy tysiące dolarów na godzinę na klastry GPU, eliminacja tego wąskiego gardła oznacza ogromne oszczędności kosztów i szybsze cykle iteracyjne.

5/ Dlaczego to ma znaczenie

Elegancka część? Nie wynaleźliśmy nowego sprzętu. Po prostu wykorzystaliśmy istniejącą technologię RDMA z inteligentnym inżynierią systemów.

Czasami najlepsze rozwiązania nie polegają na wynajdywaniu czegoś nowego - chodzi o to, aby naprawdę, naprawdę dobrze wykorzystać istniejące narzędzia.

W ten sposób budujemy w Perplexity.

To jest ogólny przegląd naszego systemu transferu wagi. Ale jestem pewien, że macie pytania, prawda?

Pytajcie mnie o wszystko.

74,62K

Najlepsze

Ranking

Ulubione