Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Acabamos de descobrir como transferir UM TRILHÃO de parâmetros entre GPUs em 1,3 segundos.

Isso é uma aceleração de 20x em relação aos métodos tradicionais.

Deixe-me mostrar como fizemos isso:

2 de out., 06:00

A transferência de peso é um dos maiores gargalos ao realizar RL distribuído em modelos de alta capacidade.

Nosso primeiro blog da Perplexity Research explica como os engenheiros de inferência da Perplexity aproveitaram a comunicação ponto a ponto RDMA para desbloquear atualizações de parâmetros ultrarrápidas para modelos de trilhões de parâmetros.

Ao aproveitar primitivos RDMA de baixo nível, agendamento estático e pipelining, aceleramos as atualizações em uma ordem de magnitude, para apenas 1,3 segundos por atualização.

1/ O problema

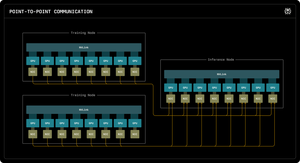

Ao treinar modelos de IA massivos com aprendizado por reforço, você precisa de dois clusters de GPU separados trabalhando juntos: GPUs de treinamento que atualizam o modelo e GPUs de inferência que o executam.

Após cada etapa do treinamento, você deve copiar todos os pesos atualizados do treinamento para a inferência. Para modelos de trilhões de parâmetros, a maioria dos sistemas leva de 30 segundos a vários MINUTOS para fazer isso.

Isso é um gargalo enorme. Sua etapa de treinamento pode levar 5 segundos, mas você espera 30 segundos apenas copiando pesos.

1/ O problema

Quando estamos treinando modelos de IA massivos com aprendizado por reforço, precisamos de dois clusters de GPU separados trabalhando juntos: GPUs de treinamento que atualizam o modelo e GPUs de inferência que o executam.

Após cada etapa do treinamento, temos que copiar todos esses pesos atualizados do treinamento para a inferência. Para o nosso modelo Kimi-K2 de trilhões de parâmetros, a maioria dos sistemas existentes leva de 30 segundos a vários MINUTOS para fazer isso.

Isso é um gargalo enorme.

Nossa etapa de treinamento pode levar 5 segundos, mas depois esperamos 30 segundos apenas copiando pesos. Inaceitável.

2/ O Caminho Antigo

Os sistemas tradicionais canalizam tudo por meio de uma GPU "rank-0". Todas as GPUs de treinamento são enviadas para uma GPU principal, que envia para uma GPU de inferência, que distribui para o resto.

É como forçar todas as correspondências a passar por uma única agência dos correios. Essa conexão se torna o gargalo - limitada a cerca de 50 gigabytes por segundo.

Sabíamos que tinha que haver uma maneira melhor.

3/ Nosso avanço

Nossa solução: RDMA WRITE - Remote Direct Memory Access.

Com o RDMA, nossas GPUs de treinamento podem gravar diretamente na memória da GPU de inferência. Sem intermediários. Sem pedir permissão. Nós apenas teletransportamos dados diretamente para a RAM de outro computador.

A GPU receptora nem é notificada. É uma operação "unilateral".

E aqui está a chave: TODAS as GPUs de treinamento se comunicam diretamente com TODAS as GPUs de inferência. Tudo de uma vez. Em paralelo. Saturamos toda a malha de rede em vez de gargalos em um único link.

Também usamos pipelining - dividindo as transferências em estágios sobrepostos para que diferentes recursos de hardware permaneçam ocupados simultaneamente.

Além disso, calculamos o cronograma de transferência uma vez na inicialização e apenas o reproduzimos. Sem sobrecarga de planejamento repetida.

4/ Nossos Resultados

Para Kimi-K2 com 1 trilhão de parâmetros: 1,3 segundos para transferir de 256 GPUs de treinamento para 128 GPUs de inferência.

Isso está movendo cerca de 2 terabytes de dados em pouco mais de um segundo. Em uma rede. Entre máquinas.

Quando estamos queimando milhares de dólares por hora em clusters de GPU, eliminar esse gargalo significa uma enorme economia de custos e ciclos de iteração mais rápidos.

4/ Nossos Resultados

Para Kimi-K2 com 1 trilhão de parâmetros: 1,3 segundos para transferir de 256 GPUs de treinamento para 128 GPUs de inferência.

Isso está movendo cerca de 2 terabytes de dados em pouco mais de um segundo. Em uma rede. Entre máquinas.

Quando estamos queimando milhares de dólares por hora em clusters de GPU, eliminar esse gargalo significa uma enorme economia de custos e ciclos de iteração mais rápidos.

5/ Por que é importante

A parte elegante? Não inventamos um novo hardware. Acabamos de usar a tecnologia RDMA existente com engenharia de sistemas inteligentes.

Às vezes, as melhores soluções não são inventar algo novo - elas são usar ferramentas existentes muito, muito bem.

É assim que construímos na Perplexity.

Então essa é a visão geral de alto nível do nosso sistema de transferência de peso. Mas tenho certeza que todos vocês têm dúvidas, certo?

Pergunte-me qualquer coisa.

163,59K

Melhores

Classificação

Favoritos