Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Chúng tôi vừa tìm ra cách chuyển giao MỘT NGÀN TỶ tham số giữa các GPU trong 1.3 giây.

Đó là tốc độ nhanh gấp 20 lần so với các phương pháp truyền thống.

Hãy để tôi cho bạn thấy cách chúng tôi đã làm điều đó:

10 giờ trước

Chuyển giao trọng lượng là một trong những nút thắt lớn nhất khi thực hiện RL phân tán trên các mô hình có dung lượng cao.

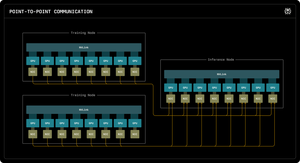

Blog nghiên cứu Perplexity đầu tiên của chúng tôi giải thích cách các kỹ sư suy diễn của Perplexity đã tận dụng giao tiếp RDMA điểm-điểm để mở khóa các cập nhật tham số siêu nhanh cho các mô hình có một triệu tỷ tham số.

Bằng cách tận dụng các nguyên tắc RDMA cấp thấp, lập lịch tĩnh và ống dẫn, chúng tôi tăng tốc các cập nhật lên một bậc, chỉ còn 1,3 giây cho mỗi lần cập nhật.

1/ Vấn đề

Khi đào tạo các mô hình AI khổng lồ bằng học tăng cường, bạn cần hai cụm GPU riêng biệt làm việc cùng nhau: GPU đào tạo cập nhật mô hình và GPU suy diễn chạy mô hình đó.

Sau mỗi bước đào tạo, bạn phải sao chép tất cả các trọng số đã cập nhật từ đào tạo sang suy diễn. Đối với các mô hình có hàng triệu tham số, hầu hết các hệ thống mất từ 30 giây đến vài PHÚT để thực hiện điều này.

Đó là một nút thắt lớn. Bước đào tạo của bạn có thể mất 5 giây, nhưng sau đó bạn phải chờ 30 giây chỉ để sao chép trọng số.

1/ Vấn đề

Khi chúng ta huấn luyện các mô hình AI khổng lồ bằng học tăng cường, chúng ta cần hai cụm GPU riêng biệt làm việc cùng nhau: GPU huấn luyện cập nhật mô hình, và GPU suy diễn chạy mô hình đó.

Sau mỗi bước huấn luyện, chúng ta phải sao chép tất cả các trọng số đã cập nhật từ huấn luyện sang suy diễn. Đối với mô hình Kimi-K2 với một triệu tham số của chúng tôi, hầu hết các hệ thống hiện có mất từ 30 giây đến vài PHÚT để thực hiện điều này.

Đó là một nút thắt lớn.

Bước huấn luyện của chúng tôi có thể mất 5 giây, nhưng sau đó chúng tôi phải chờ 30 giây chỉ để sao chép trọng số. Không thể chấp nhận.

2/ Cách Cũ

Các hệ thống truyền thống dẫn mọi thứ qua một GPU "rank-0" duy nhất. Tất cả các GPU đào tạo gửi đến một GPU chính, GPU này gửi đến một GPU suy diễn, GPU này phân phối đến phần còn lại.

Nó giống như việc buộc tất cả thư từ phải đi qua một bưu điện duy nhất. Kết nối đó trở thành nút thắt cổ chai - giới hạn khoảng 50 gigabyte mỗi giây.

Chúng tôi biết rằng phải có một cách tốt hơn.

3/ Đột phá của chúng tôi

Giải pháp của chúng tôi: RDMA WRITE - Truy cập bộ nhớ trực tiếp từ xa.

Với RDMA, các GPU đào tạo của chúng tôi có thể ghi trực tiếp vào bộ nhớ GPU suy diễn. Không có trung gian. Không cần xin phép. Chúng tôi chỉ cần dịch chuyển dữ liệu trực tiếp vào RAM của một máy tính khác.

GPU nhận không thậm chí được thông báo. Đây là một hoạt động "một chiều".

Và đây là điểm mấu chốt: MỖI GPU đào tạo đều giao tiếp trực tiếp với MỖI GPU suy diễn. Tất cả cùng một lúc. Song song. Chúng tôi làm bão hòa toàn bộ mạng thay vì gây tắc nghẽn trên một liên kết duy nhất.

Chúng tôi cũng sử dụng pipelining - chia nhỏ các chuyển giao thành các giai đoạn chồng chéo để các tài nguyên phần cứng khác nhau luôn bận rộn đồng thời.

Hơn nữa, chúng tôi tính toán lịch chuyển giao một lần khi khởi động và chỉ cần phát lại. Không có chi phí lập kế hoạch lặp lại.

4/ Kết quả của chúng tôi

Đối với Kimi-K2 với 1 triệu tỷ tham số: 1,3 giây để chuyển từ 256 GPU đào tạo sang 128 GPU suy diễn.

Điều đó có nghĩa là di chuyển khoảng 2 terabyte dữ liệu chỉ trong hơn một giây. Qua một mạng. Giữa các máy.

Khi chúng tôi đang tiêu tốn hàng nghìn đô la mỗi giờ cho các cụm GPU, việc loại bỏ nút thắt này có nghĩa là tiết kiệm chi phí lớn và chu kỳ lặp nhanh hơn.

4/ Kết quả của chúng tôi

Đối với Kimi-K2 với 1 triệu tỷ tham số: 1,3 giây để chuyển từ 256 GPU đào tạo sang 128 GPU suy diễn.

Điều đó có nghĩa là di chuyển khoảng 2 terabyte dữ liệu chỉ trong hơn một giây. Qua một mạng. Giữa các máy.

Khi chúng tôi đang tiêu tốn hàng nghìn đô la mỗi giờ cho các cụm GPU, việc loại bỏ nút thắt này có nghĩa là tiết kiệm chi phí lớn và chu kỳ lặp nhanh hơn.

5/ Tại sao điều này quan trọng

Điều tinh tế ở đây? Chúng tôi không phát minh ra phần cứng mới. Chúng tôi chỉ sử dụng công nghệ RDMA hiện có với kỹ thuật hệ thống thông minh.

Đôi khi, những giải pháp tốt nhất không phải là phát minh ra điều gì mới - mà là sử dụng các công cụ hiện có một cách thật sự, thật sự hiệu quả.

Đó là cách chúng tôi xây dựng tại Perplexity.

Vậy đó là cái nhìn tổng quan về hệ thống chuyển trọng lượng của chúng tôi. Nhưng tôi chắc chắn rằng các bạn đều có câu hỏi, đúng không?

Hãy hỏi tôi bất cứ điều gì.

74,62K

Hàng đầu

Thứ hạng

Yêu thích