Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi har nettopp funnet ut hvordan du overfører EN BILLION parametere mellom GPUer på 1.3 sekunder.

Det er en 20x hastighet i forhold til tradisjonelle metoder.

La meg vise deg hvordan vi gjorde det:

16 timer siden

Vektoverføring er en av de største flaskehalsene når du utfører distribuert RL på modeller med høy kapasitet.

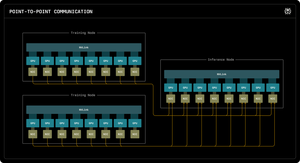

Vår første Perplexity Research-blogg forklarer hvordan Perplexitys slutningsingeniører utnyttet RDMA punkt-til-punkt-kommunikasjon for å låse opp ultraraske parameteroppdateringer for billion-parametermodeller.

Ved å utnytte RDMA-primitiver på lavt nivå, statisk planlegging og pipelining, akseler vi oppdateringer med en størrelsesorden, til bare 1,3 sekunder per oppdatering.

1/ Problemet

Når du trener massive AI-modeller med forsterkende læring, trenger du to separate GPU-klynger som jobber sammen: opplæring av GPU-er som oppdaterer modellen, og slutnings-GPU-er som kjører den.

Etter hvert treningstrinn må du kopiere alle de oppdaterte vektene fra trening til slutning. For billion-parametermodeller bruker de fleste systemer 30 sekunder til flere MINUTTER å gjøre dette.

Det er en massiv flaskehals. Treningstrinnet ditt kan ta 5 sekunder, men så venter du 30 sekunder bare ved å kopiere vekter.

1/ Problemet

Når vi trener massive AI-modeller med forsterkende læring, trenger vi to separate GPU-klynger som jobber sammen: opplæring av GPU-er som oppdaterer modellen, og slutnings-GPUer som kjører den.

Etter hvert treningstrinn må vi kopiere alle de oppdaterte vektene fra trening til slutning. For vår Kimi-K2-modell med billioner parametere bruker de fleste eksisterende systemer 30 sekunder til flere MINUTTER å gjøre dette.

Det er en massiv flaskehals.

Treningstrinnet vårt kan ta 5 sekunder, men så ville vi vente 30 sekunder bare ved å kopiere vekter. Uakseptabel.

2/ Den gamle måten

Tradisjonelle systemer kanaliserer alt gjennom en "rank-0" GPU. Alle trenings-GPUer sendes til én hoved-GPU, som sender til én slutnings-GPU, som distribueres til resten.

Det er som å tvinge all post til å gå gjennom ett enkelt postkontor. Den ene forbindelsen blir flaskehalsen - begrenset til omtrent 50 gigabyte per sekund.

Vi visste at det måtte finnes en bedre måte.

3/ Vårt gjennombrudd

Vår løsning: RDMA WRITE - Remote Direct Memory Access.

Med RDMA kan våre opplærings-GPUer skrive direkte inn i inferens-GPU-minne. Ingen mellommann. Ingen spør om tillatelse. Vi teleporterer bare data direkte til en annen datamaskins RAM.

Den mottakende GPUen blir ikke engang varslet. Det er en "ensidig" operasjon.

Og her er nøkkelen: HVER trenings-GPU snakker direkte til ALLE slutnings-GPUer. Alt på en gang. Parallelt. Vi metter hele nettverksstoffet i stedet for flaskehalser på en enkelt lenke.

Vi bruker også pipelining - å dele overføringer i overlappende stadier slik at forskjellige maskinvareressurser holder seg opptatt samtidig.

I tillegg beregner vi overføringsplanen en gang ved oppstart og spiller den bare av på nytt. Ingen gjentatte planleggingskostnader.

4/ Våre resultater

For Kimi-K2 med 1 billion parametere: 1,3 sekunder for overføring fra 256 trenings-GPUer til 128 inferens-GPUer.

Det er å flytte omtrent 2 terabyte med data på litt over et sekund. Over et nettverk. Mellom maskiner.

Når vi brenner tusenvis av dollar i timen på GPU-klynger, betyr eliminering av denne flaskehalsen enorme kostnadsbesparelser og raskere iterasjonssykluser.

4/ Våre resultater

For Kimi-K2 med 1 billion parametere: 1,3 sekunder for overføring fra 256 trenings-GPUer til 128 inferens-GPUer.

Det er å flytte omtrent 2 terabyte med data på litt over et sekund. Over et nettverk. Mellom maskiner.

Når vi brenner tusenvis av dollar i timen på GPU-klynger, betyr eliminering av denne flaskehalsen enorme kostnadsbesparelser og raskere iterasjonssykluser.

5/ Hvorfor det betyr noe

Den elegante delen? Vi oppfant ikke ny maskinvare. Vi brukte bare eksisterende RDMA-teknologi med smart systemteknikk.

Noen ganger handler ikke de beste løsningene om å finne opp noe nytt - de handler om å bruke eksisterende verktøy veldig, veldig bra.

Det er slik vi bygger på Perplexity.

Så det er den overordnede oversikten over vårt vektoverføringssystem. Men jeg er sikker på at dere alle har spørsmål, ikke sant?

Spør meg om hva som helst.

87,29K

Topp

Rangering

Favoritter