Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi har precis kommit på hur man överför EN BILJON parametrar mellan GPU:er på 1,3 sekunder.

Det är en 20x snabbare hastighet jämfört med traditionella metoder.

Låt mig visa dig hur vi gjorde det:

21 timmar sedan

Viktöverföring är en av de största flaskhalsarna när man utför distribuerad RL på modeller med hög kapacitet.

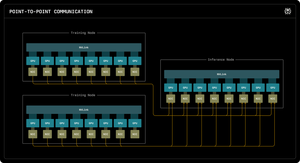

Vår första Perplexity Research-blogg förklarar hur Perplexitys inferensingenjörer utnyttjade RDMA:s punkt-till-punkt-kommunikation för att låsa upp ultrasnabba parameteruppdateringar för modeller med biljoner parametrar.

Genom att utnyttja RDMA-primitiver på låg nivå, statisk schemaläggning och pipelining påskyndar vi uppdateringar med en storleksordning, till bara 1,3 sekunder per uppdatering.

1/ Problemet

När du tränar massiva AI-modeller med förstärkt inlärning behöver du två separata GPU-kluster som arbetar tillsammans: träning av GPU:er som uppdaterar modellen och slutsatsdragnings-GPU:er som kör den.

Efter varje träningssteg måste du kopiera alla de uppdaterade vikterna från träning till slutsatsdragning. För modeller med biljoner parametrar tar de flesta system 30 sekunder till flera MINUTER för att göra detta.

Det är en enorm flaskhals. Ditt träningssteg kan ta 5 sekunder, men sedan väntar du 30 sekunder genom att bara kopiera vikter.

1/ Problemet

När vi tränar massiva AI-modeller med förstärkt inlärning behöver vi två separata GPU-kluster som arbetar tillsammans: träning av GPU:er som uppdaterar modellen och slutsatsdragnings-GPU:er som kör den.

Efter varje träningssteg måste vi kopiera alla de uppdaterade vikterna från träning till slutsatsdragning. För vår Kimi-K2-modell med biljonparametrar tar de flesta befintliga system 30 sekunder till flera MINUTER för att göra detta.

Det är en enorm flaskhals.

Vårt träningssteg kan ta 5 sekunder, men sedan skulle vi vänta 30 sekunder bara genom att kopiera vikter. Oacceptabel.

2/ Det gamla sättet

Traditionella system kanaliserar allt genom en "rank-0" GPU. Alla tränings-GPU:er skickar till en huvud-GPU, som skickar till en inferens-GPU, som distribuerar till resten.

Det är som att tvinga all post att gå genom ett enda postkontor. Den enda anslutningen blir flaskhalsen - begränsad till cirka 50 gigabyte per sekund.

Vi visste att det måste finnas ett bättre sätt.

3/ Vårt genombrott

Vår lösning: RDMA WRITE - Remote Direct Memory Access.

Med RDMA kan våra tränings-GPU:er skriva direkt till inferens-GPU-minnet. Inga mellanhänder. Du behöver inte be om lov. Vi teleporterar bara data direkt till en annan dators RAM-minne.

Den mottagande GPU:n får inte ens ett meddelande. Det är en "ensidig" operation.

Och här är nyckeln: VARJE tränings-GPU pratar direkt med VARJE inferens-GPU. Allt på en gång. Parallellt. Vi mättar hela nätverksstrukturen istället för att flaskhalsar på en enda länk.

Vi använder också pipelining - att dela upp överföringar i överlappande steg så att olika hårdvaruresurser håller sig sysselsatta samtidigt.

Dessutom beräknar vi överföringsschemat en gång vid uppstart och spelar bara upp det. Inga upprepade planeringskostnader.

4/ Våra resultat

För Kimi-K2 med 1 biljon parametrar: 1,3 sekunder för att överföra från 256 tränings-GPU:er till 128 inferens-GPU:er.

Det flyttar cirka 2 terabyte data på drygt en sekund. Över ett nätverk. Mellan maskiner.

När vi bränner tusentals dollar per timme på GPU-kluster innebär eliminering av denna flaskhals enorma kostnadsbesparingar och snabbare iterationscykler.

4/ Våra resultat

För Kimi-K2 med 1 biljon parametrar: 1,3 sekunder för att överföra från 256 tränings-GPU:er till 128 inferens-GPU:er.

Det flyttar cirka 2 terabyte data på drygt en sekund. Över ett nätverk. Mellan maskiner.

När vi bränner tusentals dollar per timme på GPU-kluster innebär eliminering av denna flaskhals enorma kostnadsbesparingar och snabbare iterationscykler.

5/ Varför det är viktigt

Den eleganta delen? Vi uppfann inte ny hårdvara. Vi använde bara befintlig RDMA-teknik med smart systemteknik.

Ibland handlar de bästa lösningarna inte om att uppfinna något nytt – det handlar om att använda befintliga verktyg riktigt, riktigt bra.

Det är så vi bygger på Perplexity.

Så det är den övergripande översikten över vårt viktöverföringssystem. Men jag är säker på att ni alla har frågor, eller hur?

Fråga mig vad som helst.

123,03K

Topp

Rankning

Favoriter