熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

我們剛剛找到了在1.3秒內在GPU之間傳輸ONE TRILLION個參數的方法。

這比傳統方法快了20倍。

讓我來告訴你我們是怎麼做到的:

16 小時前

權重轉移是執行高容量模型的分散式強化學習時最大的瓶頸之一。

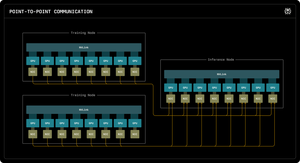

我們的第一篇 Perplexity Research 博客解釋了 Perplexity 的推理工程師如何利用 RDMA 點對點通信來解鎖超快速的參數更新,適用於萬億參數模型。

通過利用低級 RDMA 原語、靜態調度和管道化,我們將更新速度提高了十倍,僅需 1.3 秒每次更新。

1/ 問題

在使用強化學習訓練大型 AI 模型時,需要兩個獨立的 GPU 集群協同工作:訓練 GPU 用於更新模型,推理 GPU 用於運行模型。

在每次訓練步驟後,必須將所有更新的權重從訓練複製到推理。對於萬億參數的模型,大多數系統需要 30 秒到幾分鐘來完成這個過程。

這是一個巨大的瓶頸。你的訓練步驟可能只需 5 秒,但接下來你卻要等待 30 秒來複製權重。

1/ 問題

當我們使用強化學習訓練大型 AI 模型時,我們需要兩個獨立的 GPU 集群協同工作:訓練 GPU 用於更新模型,推理 GPU 用於運行模型。

在每次訓練步驟後,我們必須將所有更新的權重從訓練複製到推理。對於我們的萬億參數 Kimi-K2 模型,大多數現有系統需要 30 秒到幾分鐘來完成這個過程。

這是一個巨大的瓶頸。

我們的訓練步驟可能只需 5 秒,但接下來我們卻要等待 30 秒來複製權重。這是不可接受的。

2/ 傳統方式

傳統系統將所有內容通過一個“rank-0” GPU。所有訓練 GPU 都發送到一個主 GPU,然後該主 GPU 再發送到一個推理 GPU,最後將結果分發給其餘的 GPU。

這就像強迫所有郵件都經過一個郵局。那一個連接成為瓶頸 - 限制在每秒約 50 GB。

我們知道必須有更好的方法。

3/ 我們的突破

我們的解決方案:RDMA WRITE - 遠程直接內存訪問。

使用 RDMA,我們的訓練 GPU 可以直接寫入推理 GPU 的內存。沒有中介。無需請求許可。我們只是將數據直接傳送到另一台計算機的 RAM 中。

接收的 GPU 甚至不會收到通知。這是一個「單方面」的操作。

關鍵在於:每個訓練 GPU 都可以直接與每個推理 GPU 通信。所有同時進行。並行處理。我們充分利用整個網絡結構,而不是在單一鏈路上造成瓶頸。

我們還使用管道技術 - 將傳輸分解為重疊的階段,以便不同的硬件資源可以同時保持忙碌。

此外,我們在啟動時計算傳輸計劃,然後只需重播它。無需重複的計劃開銷。

4/ 我們的結果

對於擁有 1 兆參數的 Kimi-K2:從 256 個訓練 GPU 轉移到 128 個推理 GPU 需要 1.3 秒。

這意味著在一秒多一點的時間內移動約 2 TB 的數據。通過網絡。在機器之間。

當我們每小時在 GPU 集群上燒掉數千美元時,消除這個瓶頸意味著巨大的成本節省和更快的迭代周期。

4/ 我們的結果

對於擁有 1 兆參數的 Kimi-K2:從 256 個訓練 GPU 轉移到 128 個推理 GPU 需要 1.3 秒。

這意味著在一秒多一點的時間內移動約 2 TB 的數據。通過網絡。在機器之間。

當我們每小時在 GPU 集群上燒掉數千美元時,消除這個瓶頸意味著巨大的成本節省和更快的迭代周期。

5/ 為什麼這很重要

優雅的部分?我們並沒有發明新的硬體。我們只是利用現有的 RDMA 技術和智能系統工程。

有時候,最好的解決方案並不是發明一些新的東西 - 而是非常非常好地使用現有的工具。

這就是我們在 Perplexity 的建設方式。

這就是我們重量轉移系統的高層次概述。但我相信你們都有問題,對吧?

隨便問我任何問題。

87.29K

熱門

排行

收藏