Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nous venons de découvrir comment transférer UN TRILLION de paramètres entre des GPU en 1,3 seconde.

C'est un gain de vitesse de 20x par rapport aux méthodes traditionnelles.

Laissez-moi vous montrer comment nous l'avons fait :

il y a 10 heures

Le transfert de poids est l'un des plus grands goulets d'étranglement lors de l'exécution de l'apprentissage par renforcement distribué sur des modèles à haute capacité.

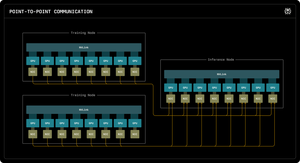

Notre premier blog de recherche Perplexity explique comment les ingénieurs en inférence de Perplexity ont exploité la communication point à point RDMA pour débloquer des mises à jour de paramètres ultra-rapides pour des modèles de trillions de paramètres.

En exploitant des primitives RDMA de bas niveau, une planification statique et le pipelining, nous accélérons les mises à jour d'un ordre de grandeur, à seulement 1,3 seconde par mise à jour.

1/ Le Problème

Lors de l'entraînement de modèles d'IA massifs avec l'apprentissage par renforcement, vous avez besoin de deux clusters GPU séparés travaillant ensemble : des GPU d'entraînement qui mettent à jour le modèle, et des GPU d'inférence qui l'exécutent.

Après chaque étape d'entraînement, vous devez copier tous ces poids mis à jour de l'entraînement à l'inférence. Pour des modèles à un trillion de paramètres, la plupart des systèmes prennent 30 secondes à plusieurs MINUTES pour le faire.

C'est un goulot d'étranglement massif. Votre étape d'entraînement peut prendre 5 secondes, mais ensuite vous attendez 30 secondes juste pour copier les poids.

1/ Le Problème

Lorsque nous formons d'énormes modèles d'IA avec l'apprentissage par renforcement, nous avons besoin de deux clusters GPU séparés travaillant ensemble : des GPU de formation qui mettent à jour le modèle, et des GPU d'inférence qui l'exécutent.

Après chaque étape de formation, nous devons copier tous ces poids mis à jour de la formation à l'inférence. Pour notre modèle Kimi-K2 à un trillion de paramètres, la plupart des systèmes existants prennent 30 secondes à plusieurs MINUTES pour le faire.

C'est un énorme goulot d'étranglement.

Notre étape de formation peut prendre 5 secondes, mais ensuite nous devrions attendre 30 secondes juste pour copier les poids. Inacceptable.

2/ La vieille méthode

Les systèmes traditionnels canalisent tout à travers un GPU « rang-0 ». Tous les GPU de formation envoient à un GPU principal, qui envoie à un GPU d'inférence, qui distribue au reste.

C'est comme forcer tout le courrier à passer par un seul bureau de poste. Cette seule connexion devient le goulet d'étranglement - limité à environ 50 gigaoctets par seconde.

Nous savions qu'il devait y avoir une meilleure façon.

3/ Notre percée

Notre solution : RDMA WRITE - Accès direct à la mémoire à distance.

Avec RDMA, nos GPU de formation peuvent écrire directement dans la mémoire GPU d'inférence. Pas d'intermédiaire. Pas de demande de permission. Nous téléportons simplement les données directement dans la RAM d'un autre ordinateur.

Le GPU récepteur n'est même pas informé. C'est une opération « unilatérale ».

Et voici la clé : CHAQUE GPU de formation communique directement avec CHAQUE GPU d'inférence. Tous en même temps. En parallèle. Nous saturons l'ensemble du réseau au lieu de créer un goulot d'étranglement sur un seul lien.

Nous utilisons également le pipelining - en divisant les transferts en étapes qui se chevauchent afin que différentes ressources matérielles restent occupées simultanément.

De plus, nous calculons le calendrier de transfert une fois au démarrage et le reproduisons simplement. Pas de surcharge de planification répétée.

4/ Nos résultats

Pour Kimi-K2 avec 1 trillion de paramètres : 1,3 secondes pour transférer de 256 GPU de formation à 128 GPU d'inférence.

Cela représente environ 2 téraoctets de données en un peu plus d'une seconde. Sur un réseau. Entre des machines.

Lorsque nous dépensons des milliers de dollars par heure sur des clusters GPU, éliminer ce goulot d'étranglement signifie d'énormes économies de coûts et des cycles d'itération plus rapides.

4/ Nos résultats

Pour Kimi-K2 avec 1 trillion de paramètres : 1,3 secondes pour transférer de 256 GPU de formation à 128 GPU d'inférence.

Cela représente environ 2 téraoctets de données en un peu plus d'une seconde. Sur un réseau. Entre des machines.

Lorsque nous dépensons des milliers de dollars par heure sur des clusters GPU, éliminer ce goulot d'étranglement signifie d'énormes économies de coûts et des cycles d'itération plus rapides.

5/ Pourquoi c'est important

La partie élégante ? Nous n'avons pas inventé de nouveau matériel. Nous avons simplement utilisé la technologie RDMA existante avec une ingénierie système intelligente.

Parfois, les meilleures solutions ne consistent pas à inventer quelque chose de nouveau - elles consistent à utiliser des outils existants vraiment, vraiment bien.

C'est ainsi que nous construisons chez Perplexity.

Voici donc un aperçu général de notre système de transfert de poids. Mais je suis sûr que vous avez tous des questions, n'est-ce pas ?

Posez-moi n'importe quelle question.

74,62K

Meilleurs

Classement

Favoris