热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

我们刚刚找到了在1.3秒内在GPU之间传输ONE万亿个参数的方法。

这比传统方法快了20倍。

让我来告诉你我们是怎么做到的:

16 小时前

权重转移是执行高容量模型的分布式强化学习时最大的瓶颈之一。

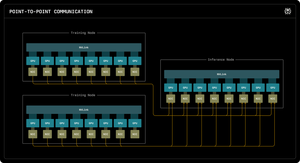

我们的第一篇 Perplexity Research 博客解释了 Perplexity 的推理工程师如何利用 RDMA 点对点通信来解锁万亿参数模型的超快速参数更新。

通过利用低级 RDMA 原语、静态调度和流水线,我们将更新加速了一个数量级,仅需 1.3 秒每次更新。

1/ 问题

在使用强化学习训练大型AI模型时,需要两个独立的GPU集群协同工作:更新模型的训练GPU和运行模型的推理GPU。

在每个训练步骤之后,您必须将所有更新的权重从训练复制到推理。对于万亿参数的模型,大多数系统需要30秒到几分钟来完成这一操作。

这造成了巨大的瓶颈。您的训练步骤可能只需5秒,但随后您需要等待30秒来复制权重。

1/ 问题

当我们使用强化学习训练大规模AI模型时,我们需要两个独立的GPU集群协同工作:更新模型的训练GPU和运行模型的推理GPU。

在每个训练步骤之后,我们必须将所有更新的权重从训练复制到推理。对于我们拥有万亿参数的Kimi-K2模型,大多数现有系统需要30秒到几分钟来完成这一过程。

这造成了巨大的瓶颈。

我们的训练步骤可能只需5秒,但随后我们需要等待30秒来复制权重。这是不可接受的。

2/ 旧方式

传统系统将所有内容通过一个“rank-0” GPU 汇聚。所有训练 GPU 都发送到一个主 GPU,然后主 GPU 再发送到一个推理 GPU,最后分发给其余的 GPU。

这就像强迫所有邮件都通过一个邮局。那一个连接成为了瓶颈——限制在每秒大约 50 吉字节。

我们知道必须有更好的方法。

3/ 我们的突破

我们的解决方案:RDMA WRITE - 远程直接内存访问。

通过RDMA,我们的训练GPU可以直接写入推理GPU的内存。没有中介。无需请求许可。我们只需将数据直接传送到另一台计算机的RAM中。

接收GPU甚至不会收到通知。这是一个“单方面”的操作。

关键在于:每个训练GPU都可以直接与每个推理GPU通信。所有操作同时进行。并行处理。我们充分利用整个网络结构,而不是在单一链路上造成瓶颈。

我们还使用流水线技术 - 将传输分解为重叠的阶段,以便不同的硬件资源可以同时保持忙碌。

此外,我们在启动时计算传输计划,并只需重放它。没有重复的规划开销。

4/ 我们的结果

对于 Kimi-K2,拥有 1 万亿个参数:从 256 个训练 GPU 转移到 128 个推理 GPU 需要 1.3 秒。

这意味着在短短一秒多一点的时间内移动约 2 TB 的数据。通过网络。在机器之间。

当我们每小时在 GPU 集群上花费数千美元时,消除这个瓶颈意味着巨大的成本节省和更快的迭代周期。

4/ 我们的结果

对于 Kimi-K2,拥有 1 万亿个参数:从 256 个训练 GPU 转移到 128 个推理 GPU 需要 1.3 秒。

这意味着在短短一秒多一点的时间内移动约 2 TB 的数据。通过网络。在机器之间。

当我们每小时在 GPU 集群上花费数千美元时,消除这个瓶颈意味着巨大的成本节省和更快的迭代周期。

5/ 为什么这很重要

优雅的部分?我们并没有发明新的硬件。我们只是利用了现有的 RDMA 技术和智能系统工程。

有时候,最好的解决方案并不是发明一些新东西——而是非常非常好地使用现有工具。

这就是我们在 Perplexity 的构建方式。

这就是我们重量转移系统的高层概述。但我相信你们都有问题,对吧?

随便问我任何问题。

87.29K

热门

排行

收藏