Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Acabamos de descubrir cómo transferir UN BILLÓN de parámetros entre GPUs en 1.3 segundos.

Eso es un aumento de velocidad de 20 veces en comparación con los métodos tradicionales.

Déjame mostrarte cómo lo hicimos:

2 oct, 06:00

La transferencia de peso es uno de los mayores cuellos de botella al realizar RL distribuido en modelos de alta capacidad.

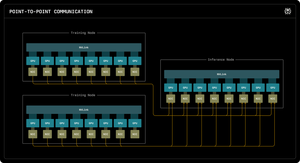

Nuestro primer blog de Perplexity Research explica cómo los ingenieros de inferencia de Perplexity aprovecharon la comunicación RDMA punto a punto para desbloquear actualizaciones de parámetros ultra rápidas para modelos de un billón de parámetros.

Al aprovechar los primitivos RDMA de bajo nivel, la programación estática y el pipelining, aceleramos las actualizaciones en un orden de magnitud, a solo 1.3 segundos por actualización.

1/ El Problema

Al entrenar modelos de IA masivos con aprendizaje por refuerzo, necesitas dos clústeres de GPU separados que trabajen juntos: GPUs de entrenamiento que actualizan el modelo y GPUs de inferencia que lo ejecutan.

Después de cada paso de entrenamiento, tienes que copiar todos esos pesos actualizados de entrenamiento a inferencia. Para modelos de un billón de parámetros, la mayoría de los sistemas tardan de 30 segundos a varios MINUTOS en hacer esto.

Eso es un gran cuello de botella. Tu paso de entrenamiento puede tardar 5 segundos, pero luego esperas 30 segundos solo para copiar los pesos.

1/ El Problema

Cuando estamos entrenando modelos de IA masivos con aprendizaje por refuerzo, necesitamos dos clústeres de GPU separados trabajando juntos: GPUs de entrenamiento que actualizan el modelo y GPUs de inferencia que lo ejecutan.

Después de cada paso de entrenamiento, tenemos que copiar todos esos pesos actualizados de entrenamiento a inferencia. Para nuestro modelo Kimi-K2 de un billón de parámetros, la mayoría de los sistemas existentes tardan de 30 segundos a varios MINUTOS en hacer esto.

Eso es un gran cuello de botella.

Nuestro paso de entrenamiento puede tardar 5 segundos, pero luego esperaríamos 30 segundos solo para copiar los pesos. Inaceptable.

2/ El Viejo Método

Los sistemas tradicionales canalizan todo a través de una GPU "rank-0". Todas las GPUs de entrenamiento envían a una GPU principal, que envía a una GPU de inferencia, que distribuye al resto.

Es como obligar a que toda la correspondencia pase por una única oficina de correos. Esa única conexión se convierte en el cuello de botella, limitado a aproximadamente 50 gigabytes por segundo.

Sabíamos que tenía que haber una mejor manera.

3/ Nuestro Avance

Nuestra solución: RDMA WRITE - Acceso Directo a Memoria Remota.

Con RDMA, nuestras GPUs de entrenamiento pueden escribir directamente en la memoria de la GPU de inferencia. Sin intermediarios. Sin pedir permiso. Simplemente teletransportamos datos directamente a la RAM de otra computadora.

La GPU receptora ni siquiera recibe una notificación. Es una operación "unilateral".

Y aquí está la clave: CADA GPU de entrenamiento se comunica directamente con CADA GPU de inferencia. Todo al mismo tiempo. En paralelo. Saturamos toda la red en lugar de crear un cuello de botella en un solo enlace.

También utilizamos el pipelining: descomponemos las transferencias en etapas superpuestas para que diferentes recursos de hardware permanezcan ocupados simultáneamente.

Además, calculamos el horario de transferencia una vez al inicio y simplemente lo reproducimos. Sin sobrecarga de planificación repetida.

4/ Nuestros Resultados

Para Kimi-K2 con 1 billón de parámetros: 1.3 segundos para transferir de 256 GPUs de entrenamiento a 128 GPUs de inferencia.

Eso significa mover alrededor de 2 terabytes de datos en poco más de un segundo. A través de una red. Entre máquinas.

Cuando estamos gastando miles de dólares por hora en clústeres de GPU, eliminar este cuello de botella significa enormes ahorros de costos y ciclos de iteración más rápidos.

4/ Nuestros Resultados

Para Kimi-K2 con 1 billón de parámetros: 1.3 segundos para transferir de 256 GPUs de entrenamiento a 128 GPUs de inferencia.

Eso significa mover alrededor de 2 terabytes de datos en poco más de un segundo. A través de una red. Entre máquinas.

Cuando estamos gastando miles de dólares por hora en clústeres de GPU, eliminar este cuello de botella significa enormes ahorros de costos y ciclos de iteración más rápidos.

5/ Por qué es importante

¿La parte elegante? No inventamos nuevo hardware. Solo utilizamos la tecnología RDMA existente con una ingeniería de sistemas inteligente.

A veces, las mejores soluciones no se tratan de inventar algo nuevo, sino de usar herramientas existentes de manera realmente, realmente efectiva.

Así es como construimos en Perplexity.

Así que esa es la visión general de nuestro sistema de transferencia de peso. Pero estoy seguro de que todos tienen preguntas, ¿verdad?

Pregúntenme cualquier cosa.

163,59K

Parte superior

Clasificación

Favoritos