المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

تتمتع Prime-rl الآن بدعم واسع النطاق لوزارة التربية والتعليم لكل من RL و SFT ، وقد قمنا بتدريب نموذج 100B + معها

لدينا دعم ل:

* Qwen3 a3-30b

* سلسلة GLM وضوء القمر

* إضافة سلسلة GPT OSS كما نتحدث

ينتهي بنا الأمر بإعادة كتابة معظم كود النمذجة لجعلها تعمل مع Torch Compil مع الاستمرار في التوافق مع النظام البيئي Hugging Face

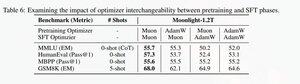

أضفنا أيضا دعما لضبط سلسلة glm مع Muon حيث وجدنا أنها تجعل طريقة التدريب أكثر استقرارا على نموذج muon pretrain. هذا يرتبط جيدا بالاكتشاف في ورقة ضوء القمر.

نحن نستخدم تطبيق Microsoft في dion

من ناحية الأداء ، نحن على قدم المساواة مع تدريب torchtitan moe (ويرجع ذلك أساسا إلى أننا أخذنا torchtitan كمرجع لتحسين الكود الخاص بنا).

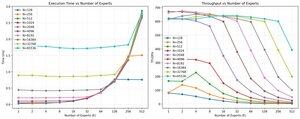

نصل إلى 20٪ mfu على 100B glm air moe في تدريب 65K seq len على 512 h200 GPU مع الميون. من حيث التوازي ، اكتشفنا أن torchtitan EP لم يتم تحسينه كثيرا لوزارة التربية والتعليم المتناثر ولم ينتج عنه أي تسريع ذي مغزى بحجم دفعة كبير بما يكفي.

يبدو أنه يمكننا تشبع أداء نواة المجموعة مم لوزارة التربية والتعليم بسرعة كبيرة وأن القيام بموازنة تحميل أفضل مع EP يؤدي إلى تناقص العائد بسبب حجب الكل للجميع.

نعتقد أن هناك مجالا كبيرا للتحسين عبر مجموعة المصادر المفتوحة لوزارة التربية. هناك حاجة ماسة للنواة المحسنة لجعل MoEs أسرع وإخفاء الاتصال والحساب بطريقة دقيقة للغاية. يبدو أن هناك حاجة أكبر لبلاكويل

آه أيضا ، تم إنجاز معظم العمل على وزارة التربية والتعليم بواسطة @jackminong

19.93K

الأفضل

المُتصدِّرة

التطبيقات المفضلة