Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl har nå omfattende støtte for MoE både for RL og SFT, vi har trent 100B+ modell med den

Vi har støtte for:

* Qwen3 a3-30b

* GLM-serien og Moonlight

* Legger til GPT OSS-serien mens vi snakker

Vi ender opp med å skrive om det meste av modelleringskoden for å få den til å fungere med Torch Comile samtidig som den er kompatibel med Hugging Face-økosystemet

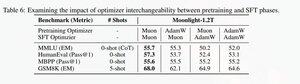

Vi la også til støtte for å finjustere glm-serien med Muon da vi fant ut at den gjorde treningen mye mer stabil på myon pretrain-modellen. Dette korrelerer godt med funn i måneskinnsartikkelen.

Vi bruker Microsoft-implementeringen i dion

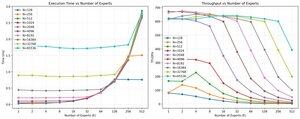

Ytelsesmessig er vi på nivå med torchtitan moe-trening (hovedsakelig fordi vi tok torchtitan som referanse for å optimalisere koden vår).

Vi når 20 % mfu på 100B glm air moe ved 65K seq len trening på 512 h200 gpu med myon. Når det gjelder parallellitet, fant vi ut at torchtitan EP ikke er så mye optimalisert for sparsomme MoE-er, og det ga ingen meningsfull speedup med stor nok batchstørrelse.

Det ser ut til at vi kan mette ytelsen til gruppe mm-kjernen for MoEs ganske raskt, og at bedre lastbalansering med EP gir redusert avkastning på grunn av blokkeringen alt til alle.

Vi tror at det er mye rom for forbedring på tvers av åpen kildekode-stabelen for MoEs. Det er et sterkt behov for optimaliserte kjerner for å gjøre MoEs raskere og for å skjule kommunikasjon og beregning på en veldig finkornet måte. Det ser ut til å være enda mer nødvendig for blackwell

ah også det meste av arbeidet med Moe har blitt gjort av @jackminong

20,88K

Topp

Rangering

Favoritter