Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl hiện đã hỗ trợ rộng rãi cho MoE cả cho RL và SFT, chúng tôi đã huấn luyện mô hình 100B+ với nó

Chúng tôi có hỗ trợ cho:

* Qwen3 a3-30b

* Dòng GLM và Moonlight

* thêm gpt oss series trong khi chúng tôi đang nói chuyện

chúng tôi đã phải viết lại hầu hết mã mô hình để làm cho nó hoạt động với torch compile trong khi vẫn tương thích với hệ sinh thái hugging face.

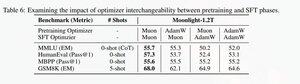

Chúng tôi cũng đã thêm hỗ trợ để tinh chỉnh chuỗi glm với Muon vì chúng tôi thấy nó làm cho việc đào tạo trở nên ổn định hơn nhiều trên mô hình tiền huấn luyện muon. Điều này tương quan tốt với phát hiện trong tài liệu moonlight.

Chúng tôi đang sử dụng triển khai của Microsoft trong dion

Về hiệu suất, chúng tôi đang ở mức tương đương với đào tạo torchtitan moe (chủ yếu vì chúng tôi đã lấy torchtitan làm tham chiếu để tối ưu hóa mã của mình).

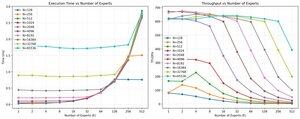

Chúng tôi đạt 20% mfu trên 100B glm air moe với đào tạo 65K seq len trên 512 h200 gpu với muon. Về mặt song song, chúng tôi phát hiện ra rằng torchtitan EP không được tối ưu hóa nhiều cho MoEs thưa thớt và nó không mang lại bất kỳ sự tăng tốc có ý nghĩa nào với kích thước lô đủ lớn.

Có vẻ như chúng tôi có thể bão hòa hiệu suất của nhân mm nhóm cho MoEs khá nhanh và việc thực hiện cân bằng tải tốt hơn với EP mang lại lợi nhuận giảm dần do việc chặn tất cả với tất cả.

Chúng tôi tin rằng còn nhiều không gian để cải thiện trong toàn bộ ngăn xếp mã nguồn mở cho MoEs. Có một nhu cầu mạnh mẽ về các nhân tối ưu hóa để làm cho MoEs nhanh hơn và để ẩn giao tiếp và tính toán theo cách rất tinh vi. Có vẻ như điều này càng cần thiết hơn cho blackwell.

ah, hầu hết công việc trên moe đã được thực hiện bởi @jackminong

20,88K

Hàng đầu

Thứ hạng

Yêu thích