Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl are acum suport extins pentru MoE atât pentru RL, cât și pentru SFT, am antrenat modelul 100B+ cu el

Avem suport pentru:

* Qwen3 a3-30b

* Seria GLM și Moonlight

* Adăugarea seriei GPT OSS în timp ce vorbim

Ajungem să rescriem cea mai mare parte a codului de modelare pentru a-l face să funcționeze cu Torch Compile, fiind în același timp compatibil cu ecosistemul Hugging Face

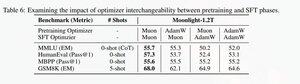

De asemenea, am adăugat suport pentru a regla fin seria glm cu Muon, deoarece am descoperit că face antrenamentul mult mai stabil pe modelul de preantrenament Muon. Acest lucru se corelează bine cu descoperirea din lucrarea la lumina lunii.

Folosim implementarea Microsoft in dion

Din punct de vedere al performanței, suntem la egalitate cu antrenamentul torchtitan moe (în principal pentru că am luat torchtitan ca referință pentru optimizarea codului nostru).

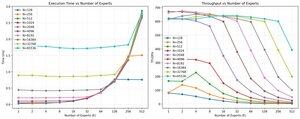

Ajungem la 20% mfu pe moe de aer 100B glm la 65K seq len antrenament pe 512 h200 gpu cu muon. În ceea ce privește paralelismul, am aflat că torchtitan EP nu este atât de optimizat pentru MoE rare și nu a produs nicio accelerare semnificativă cu o dimensiune suficient de mare a lotului.

Se pare că putem satura performanța nucleului de grup mm pentru MoE destul de repede și că o mai bună echilibrare a încărcării cu EP produce un randament scăzător din cauza blocării tuturor

Credem că există mult loc de îmbunătățire în stiva open source pentru MoE. Există o nevoie puternică de nuclee optimizate pentru a face MoEs mai rapid și pentru a ascunde comunicarea și calculul într-un mod foarte fin. Se pare că este și mai necesar pentru blackwell

Ah, de asemenea, cea mai mare parte a muncii la MOE a fost făcută de @jackminong

19,93K

Limită superioară

Clasament

Favorite