Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

O Prime-rl agora tem um suporte extenso para MoE tanto para RL quanto para SFT, temos treinado um modelo de 100B+ com isso

Temos suporte para:

* Qwen3 a3-30b

* série GLM e Moonlight

* adicionando a série gpt oss enquanto falamos

acabamos reescrevendo a maior parte do código de modelagem para fazê-lo funcionar com torch compile, mantendo a compatibilidade com o ecossistema hugging face.

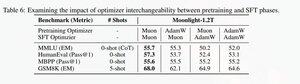

Também adicionámos suporte para ajustar a série glm com Muon, pois descobrimos que isso torna o treinamento muito mais estável no modelo de pré-treinamento muon. Isso correlaciona-se bem com as descobertas no artigo moonlight.

Estamos a usar a implementação da Microsoft em dion

Em termos de desempenho, estamos ao nível do treinamento torchtitan moe (principalmente porque usamos o torchtitan como referência para otimizar nosso código).

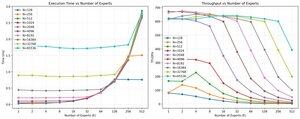

Alcançamos 20% de mfu no 100B glm air moe com 65K seq len de treinamento em 512 h200 gpu com muon. Em termos de paralelismo, descobrimos que o EP do torchtitan não está tão otimizado para MoEs esparsos e não resultou em nenhum aumento significativo de velocidade com um tamanho de lote grande o suficiente.

Parece que conseguimos saturar rapidamente o desempenho do kernel mm do grupo para MoEs e que fazer um melhor balanceamento de carga com EP gera retornos decrescentes devido ao bloqueio total.

Acreditamos que há muito espaço para melhorias em toda a pilha de código aberto para MoEs. Há uma forte necessidade de kernels otimizados para tornar os MoEs mais rápidos e para ocultar a comunicação e a computação de uma maneira muito detalhada. Parece ser ainda mais necessário para blackwell.

ah, também a maior parte do trabalho no moe foi feito por @jackminong

20,89K

Top

Classificação

Favoritos