Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl har nu omfattande stöd för MoE både för RL och SFT, vi har tränat 100B+ modellen med den

Vi har stöd för:

* Qwen3 A3-30B

* GLM-serien och Moonlight

* Lägger till GPT OSS-serien i skrivande stund

Det slutar med att vi skriver om det mesta av modelleringskoden för att få den att fungera med Torch Compile samtidigt som den fortfarande är kompatibel med Hugging Face-ekosystemet

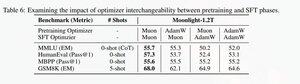

Vi har också lagt till stöd för att finjustera glm-serien med Muon eftersom vi tyckte att det gjorde träningen mycket stabilare på myon-förtågsmodellen. Detta korrelerar väl med att hitta i månskenspappret.

Vi använder Microsoft-implementeringen i dion

Prestandamässigt är vi i nivå med torchtitan moe-träning (främst för att vi tog torchtitan som referens för att optimera vår kod).

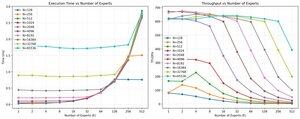

Vi når 20% mfu på 100B glm air moe vid 65K seq len träning på 512 h200 gpu med myon. När det gäller parallellitet fick vi reda på att torchtitan EP inte är så mycket optimerad för glesa MoEs och att den inte gav någon meningsfull speedup med tillräckligt stor batchstorlek.

Det verkar som att vi kan mätta prestandan hos grupp mm-kärnan för MoEs ganska snabbt och att bättre lastbalansering med EP ger minskande avkastning på grund av blockeringen helt och hållet.

Vi tror att det finns mycket utrymme för förbättringar i hela öppen källkodsstacken för MoE. Det finns ett stort behov av optimerade kärnor för att göra MoE snabbare och för att dölja kommunikation och beräkning på ett mycket finkornigt sätt. Det verkar vara ännu mer nödvändigt för blackwell

Det mesta av arbetet med MOE har också gjorts av @jackminong

19,92K

Topp

Rankning

Favoriter