Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl:llä on nyt laaja tuki MoE:lle sekä RL:lle että SFT:lle, olemme kouluttaneet sen kanssa 100B+-mallia

Tuemme seuraavia:

* Qwen3 a3-30b

* GLM-sarja ja Moonlight

* GPT OSS-sarjan lisääminen puhuessamme

Päädymme kirjoittamaan suurimman osan mallinnuskoodista uudelleen, jotta se toimisi Torch Compilen kanssa ja olisi silti yhteensopiva Hagging Face -ekosysteemin kanssa

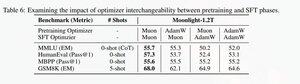

Lisäsimme myös tuen glm-sarjan hienosäätöön Muonilla, koska huomasimme sen tekevän harjoittelusta paljon vakaampaa myonin esiharjoitusmallissa. Tämä korreloi hyvin kuutamopaperin löydösten kanssa.

Käytämme Microsoftin toteutusta dionissa

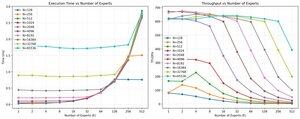

Suorituskyvyn suhteen olemme samalla tasolla torchtitan moe -koulutuksen kanssa (lähinnä siksi, että otimme torchtitanin referenssiksi koodimme optimoinnissa).

Saavutamme 20 % mfu:n 100B glm air moe:lla 65K seq len -harjoittelulla 512 h200 gpu:lla myonilla. Rinnakkaisuuden suhteen huomasimme, että torchtitan EP:tä ei ole juurikaan optimoitu harvoille MoE:ille, eikä se tuottanut mitään merkittävää nopeutusta, kun eräkoko on riittävän suuri.

Näyttää siltä, että voimme kyllästää ryhmän mm-ytimen suorituskyvyn MoEs:lle melko nopeasti ja että parempi kuormituksen tasapainotus EP:llä tuottaa pienenevän tuoton, koska kaikki estetään kaikille.

Uskomme, että MoEs:n avoimen lähdekoodin pinossa on paljon parantamisen varaa. On olemassa suuri tarve optimoiduille ytimille, jotka nopeuttavat MoE:tä ja piilottavat viestinnän ja laskennan erittäin hienorakeisella tavalla. Sitä näyttää tarvitsevan vielä enemmän Blackwellille

Ah myös suurin osa Moe-työstä on tehty @jackminong

19,93K

Johtavat

Rankkaus

Suosikit