Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl sekarang memiliki dukungan ekstensif untuk MoE baik untuk RL dan SFT, kami telah melatih model 100B+ dengannya

Kami memiliki dukungan untuk:

* Qwen3 a3-30b

* Seri GLM dan Moonlight

* Menambahkan seri GPT OSS saat kita berbicara

Kami akhirnya menulis ulang sebagian besar kode pemodelan untuk membuatnya berfungsi dengan kompilasi Torch sambil tetap kompatibel dengan ekosistem Hugging Face

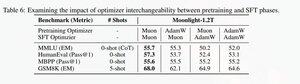

Kami juga menambahkan dukungan untuk menyempurnakan seri glm dengan Muon karena kami menemukannya membuat pelatihan jauh lebih stabil pada model pretrain muon. Ini berkorelasi baik dengan penemuan dalam kertas cahaya bulan.

Kami menggunakan implementasi Microsoft di dion

Dari segi kinerja, kami setara dengan pelatihan torchtitan moe (terutama karena kami mengambil torchtitan sebagai referensi untuk mengoptimalkan kode kami).

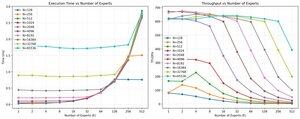

Kami mencapai 20% mfu pada 100B glm air moe pada 65K seq len pelatihan pada 512 h200 gpu dengan muon. Dalam hal paralelisme, kami menemukan bahwa torchtitan EP tidak terlalu dioptimalkan untuk MoE yang jarang dan tidak menghasilkan percepatan yang berarti dengan ukuran batch yang cukup besar.

Tampaknya kita dapat menjenuhkan kinerja kernel mm grup untuk MoE dengan cukup cepat dan melakukan penyeimbangan beban yang lebih baik dengan EP menghasilkan pengembalian yang berkurang karena pemblokiran semua untuk semua.

Kami percaya bahwa ada banyak ruang untuk perbaikan di seluruh tumpukan open source untuk MoE. Ada kebutuhan kuat untuk kernel yang dioptimalkan untuk membuat MoE lebih cepat dan untuk menyembunyikan komunikasi dan komputasi dengan cara yang sangat halus. Tampaknya lebih dibutuhkan untuk blackwell

Ah juga sebagian besar pekerjaan pada Moe telah dilakukan oleh @jackminong

19,94K

Teratas

Peringkat

Favorit