Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl hat jetzt umfassende Unterstützung für MoE sowohl für RL als auch für SFT, wir haben ein Modell mit über 100B trainiert.

Wir unterstützen:

* Qwen3 a3-30b

* GLM-Serie und Moonlight

* wir fügen gerade die gpt oss-Serie hinzu

Wir haben den Großteil des Modellierungscodes umgeschrieben, um es mit torch compile zum Laufen zu bringen, während es weiterhin mit dem Hugging Face-Ökosystem kompatibel ist.

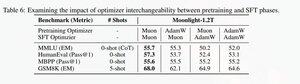

Wir haben auch Unterstützung hinzugefügt, um die glm-Serie mit Muon zu verfeinern, da wir festgestellt haben, dass es das Training auf dem Muon-Vortrainingsmodell viel stabiler macht. Dies korreliert gut mit den Ergebnissen aus dem Moonlight-Papier.

Wir verwenden die Microsoft-Implementierung in Dion.

Leistungsseitig sind wir auf Augenhöhe mit dem torchtitan moe Training (hauptsächlich, weil wir torchtitan als Referenz für die Optimierung unseres Codes genommen haben).

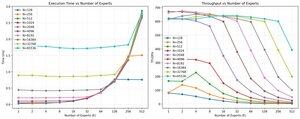

Wir erreichen 20% mfu beim 100B glm air moe mit 65K seq len Training auf 512 h200 GPU mit muon. In Bezug auf Parallelität haben wir festgestellt, dass torchtitan EP nicht so stark für spärliche MoEs optimiert ist und es keinen nennenswerten Geschwindigkeitsvorteil bei ausreichend großer Batch-Größe gebracht hat.

Es scheint, dass wir die Leistung des group mm Kernels für MoEs ziemlich schnell ausschöpfen können und dass eine bessere Lastverteilung mit EP abnehmende Erträge bringt, aufgrund des Blocking all to all.

Wir glauben, dass es viel Raum für Verbesserungen im gesamten Open-Source-Stack für MoEs gibt. Es besteht ein starker Bedarf an optimierten Kernen, um MoEs schneller zu machen und Kommunikation und Berechnung auf sehr feinkörnige Weise zu verbergen. Es scheint sogar noch notwendiger für blackwell zu sein.

ah, also der Großteil der Arbeit an moe wurde von @jackminong erledigt

20,89K

Top

Ranking

Favoriten