Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Зараз Prime-rl має широку підтримку MoE як для RL, так і для SFT, ми тренували модель 100B+ з її допомогою

Ми підтримуємо щодо:

* Qwen3 a3-30b

* Серія GLM і Moonlight

* Додавання серії GPT OSS під час розмови

У підсумку ми переписуємо більшу частину коду моделювання, щоб він працював з компіляцією Torch, залишаючись при цьому сумісним з екосистемою Hugging Face

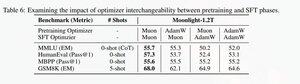

Ми також додали підтримку для точного налаштування серії glm з Muon, оскільки ми виявили, що це робить тренування більш стабільними на моделі muon pretrain. Це добре корелює з пошуком у місячному світлі паперу.

Ми використовуємо реалізацію Microsoft в dion

За продуктивністю ми знаходимося на одному рівні з тренуванням torchtitan moe (головним чином тому, що ми взяли torchtitan як орієнтир для оптимізації нашого коду) .

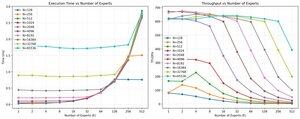

Ми досягаємо 20% mfu на 100B glm air moe при 65K seq len тренування на 512 h200 gpu з мюоном. З точки зору паралелізму ми з'ясували, що EP torchtitan не так сильно оптимізований для розріджених МОЕ, і він не дав якогось значущого прискорення при досить великому розмірі партії.

Схоже, що ми можемо досить швидко наситити продуктивність групового мм ядра для MoEs, і що краще балансування навантаження з EP дає спадну віддачу через блокування все до всіх.

Ми вважаємо, що є багато можливостей для вдосконалення в стеку з відкритим вихідним кодом для MoEs. Існує велика потреба в оптимізованих ядрах, щоб зробити MoEs швидшими та приховати зв'язок та обчислення у дуже тонкий спосіб. Здається, він ще більше потрібен для блеквелла

А ще більша частина роботи по МО була виконана @jackminong

19,93K

Найкращі

Рейтинг

Вибране